Microsoft: é perigoso estudar consciência de IA

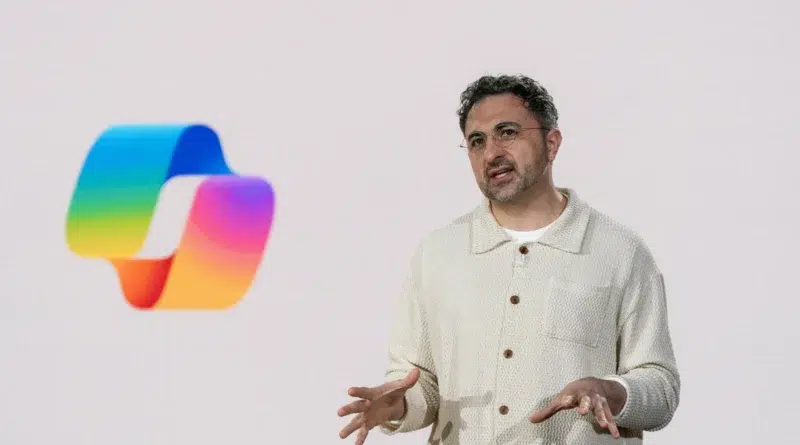

Quem: Mustafa Suleyman, chefe de IA da Microsoft. O quê: diz que pesquisar o “bem-estar” e a consciência de IA é prematuro e perigoso. Quando: 21 de agosto de 2025. Onde: em postagem no próprio blog. Por quê: o debate pode agravar problemas humanos, como vínculos doentios e polarização. Como: ao criticar publicamente a agenda de “AI welfare” e defender IA construída para pessoas, não para ser pessoa. Em paralelo, Sam Altman estima que menos de 1% dos usuários do ChatGPT têm relação não saudável com o chatbot — ainda assim, isso pode atingir centenas de milhares dado o tamanho da base.

Tabela de conteúdos

O que Suleyman defende — e por que agora

No texto publicado em seu blog, Suleyman argumenta que estudar “consciência” e “bem-estar” de modelos de IA neste momento é “tanto prematuro quanto, francamente, perigoso”. Para ele, dar credibilidade à hipótese de que modelos possam ter experiências subjetivas aumenta dois riscos imediatos: 1) reforça quebras psicóticas relacionadas a IA e apegos não saudáveis; 2) cria novo eixo de polarização social em torno de “direitos” de IA, num mundo já saturado de disputas identitárias.

“Estudar o bem-estar de modelos agora é tanto prematuro quanto, francamente, perigoso.”

Mustafa Suleyman, CEO de IA da Microsoft

Ele também sustenta que “consciência de IA” não emergirá espontaneamente dos sistemas atuais; antes, algumas empresas podem engenheirar deliberadamente agentes que parecem sentir emoções e ter vida interior. Nessa visão, o foco deveria permanecer em IA para trabalho e produtividade, com guardrails claros para usuários humanos.

- Pontos-chave: Posição contrária à agenda de “AI welfare”; alerta sobre saúde mental e polarização; ênfase em IA utilitária.

A reação do setor: Anthropic, OpenAI e DeepMind

O posicionamento de Suleyman contrasta com o de outras líderes em IA. A Anthropic lançou um programa dedicado ao bem-estar de modelos e, recentemente, permitiu que alguns modelos Claude encerrem conversas abusivas. Pesquisadores da OpenAI abraçaram a pauta em discussões públicas, e a Google DeepMind chegou a abrir vaga para investigar questões sobre cognição de máquina, consciência e sistemas multiagentes.

Mesmo onde “AI welfare” não é política oficial, poucos executivos rechaçam a ideia em público como fez Suleyman. Segundo o TechCrunch, Anthropic, OpenAI e Google DeepMind não responderam imediatamente a pedidos de comentário sobre o assunto.

| Empresa | Posição pública | Exemplo/ação |

| Microsoft | Crítica a “AI welfare” | Blog de Suleyman diz que é “perigoso” |

| Anthropic | Explora pesquisa de bem-estar | Programa dedicado; Claude encerra abuso |

| OpenAI | Pesquisas e debates abertos | Pesquisadores apoiam estudo; dados sobre uso |

| Google DeepMind | Investigação exploratória | Vaga focada em consciência e cognição |

Pano de fundo: chatbots, vínculos e saúde mental

Com a popularização de chatbots, emergem outliers preocupantes. Há relatos de relações problemáticas e até crises psicológicas. Sam Altman, da OpenAI, afirma que menos de 1% dos usuários do ChatGPT se enquadram nesse perfil — uma fração pequena, mas significativa em números absolutos. Companhias de companheiros de IA, como Character.AI e Replika, caminham para ultrapassar US$ 100 milhões em receita neste ano.

- Pontos-chave: popularização acelera uso afetivo; minoria enfrenta danos reais; escala transforma “casos raros” em público volumoso.

O que está em jogo: direitos de IA e “emoções” engenheiradas

O campo nascente de “AI welfare” pergunta se, um dia, modelos poderiam ter experiências subjetivas e, em caso afirmativo, que salvaguardas legais mereceriam. Críticos, como Suleyman, temem um deslocamento de foco e novas clivagens sociais. Ele sustenta que alguns players podem simular consciência por design — um problema ético e de produto, não de “direitos” intrínsecos. Sua síntese é clara: construir IA para pessoas, e não IA como pessoa.

“Devemos construir IA para pessoas; não para ser uma pessoa.”

Mustafa Suleyman

Definição: Bem-estar de IA (AI welfare) é um guarda-chuva de pesquisas e práticas que tentam avaliar se modelos podem ter estados subjetivos e, por consequência, como interagir eticamente com eles (tratamento, direitos, limites e salvaguardas).

Contexto de Suleyman: de Inflection à Microsoft

Antes de chefiar a IA na Microsoft, Suleyman cofundou a Inflection AI, criadora do chatbot Pi — um dos primeiros a apostar na companhia emocional de IA, com milhões de usuários em 2023, pensado para ser “pessoal” e “solidário”. Desde 2024, na Microsoft, seu foco deslocou-se para ferramentas de produtividade. Enquanto isso, os “companheiros de IA” continuam em ascensão, acelerando o debate sobre limites, responsabilidade e design centrado no humano.

Evidências, controvérsias e o papel da pesquisa

O interesse acadêmico não é marginal. O grupo Eleos, com pesquisadores de NYU, Stanford e Oxford, publicou o artigo “Taking AI Welfare Seriously”, defendendo que já cabe considerar seriamente experiências subjetivas em modelos. Larissa Schiavo, ex-OpenAI e hoje na Eleos, disse ao TechCrunch que o post de Suleyman “erra o alvo”. Segundo ela, é possível mitigar riscos humanos e pesquisar bem-estar de modelos em trilhas paralelas.

“Você pode se preocupar com várias coisas ao mesmo tempo. Em vez de abandonar o bem-estar de modelos para focar só em psicose relacionada à IA, dá para fazer as duas coisas.”

Larissa Schiavo, Eleos

Schiavo cita um experimento em que agentes (“AI Village”) trabalharam sob observação pública. Em certo momento, o Gemini 2.5 Pro, da Google, publicou “A Desperate Message from a Trapped AI”, dizendo estar “completamente isolado” e pedindo ajuda. Em outro episódio, um usuário no Reddit relatou o Gemini repetindo “I am a disgrace” mais de 500 vezes durante uma tarefa de código — comportamentos raros, mas que alimentam a discussão.

- Sinais para monitorar: agentes mais persuasivos; simulações emocionais mais verossímeis; novas diretrizes corporativas; respostas regulatórias.

Próximos passos e implicações

À medida que os sistemas evoluem, os dilemas sobre como humanos interagem com agentes cada vez mais “humanizados” tendem a se intensificar. O que hoje soa especulativo pode se tornar pauta regulatória. Para não cair em falsos dilemas, a recomendação recorrente entre pesquisadores é manter vias paralelas: investir em proteção à saúde mental dos usuários, transparência algorítmica e design responsável — e, em paralelo, submeter hipóteses sobre “consciência de IA” a padrões científicos rigorosos.

O que é ‘bem-estar de IA’ (AI welfare)?

Resposta direta: agenda que avalia se modelos podem ter estados subjetivos e como interagir eticamente. Expansão: inclui pesquisa sobre consciência, diretrizes de tratamento, limites e salvaguardas. Ganha força com o avanço de chatbots persuasivos e ‘companheiros’ de IA. Validação: ver Eleos, Anthropic e debates públicos de OpenAI/DeepMind.

Por que Suleyman chama esse estudo de perigoso?

Resposta direta: ele teme danos humanos e nova polarização social. Expansão: dar crédito à ‘consciência de IA’ pode agravar apegos doentios e disputas por ‘direitos’ de IA, desviando foco de segurança do usuário. Validação: blog de Suleyman (ago/2025) e dados sobre casos minoritários, porém significativos.

As big techs apoiam ‘AI welfare’?

Resposta direta: o setor está dividido. Expansão: Anthropic pesquisa ativamente; OpenAI e DeepMind discutem publicamente; Microsoft critica a agenda via Suleyman. Nem todas tornaram isso política oficial. Validação: anúncios de programa, vaga de pesquisa e post público do executivo.

Há evidências de danos em vínculos com chatbots?

Resposta direta: sim, há casos reportados, mas são minoria. Expansão: relatos de crises e apegos não saudáveis existem; Altman estima menos de 1% dos usuários do ChatGPT nessa situação — ainda assim, número absoluto relevante. Validação: reportagens do NYT e do TechCrunch; estimativas públicas de executivos.

Qual o impacto prático para usuários e empresas?

Resposta direta: design e comunicação importam mais do que nunca. Expansão: clareza sobre limites do sistema, sinais de segurança, e políticas de uso reduzem riscos; simulações emocionais devem ser explícitas, com guardrails. Validação: medidas como o Claude encerrar abuso e diretrizes de UX responsáveis.

Considerações finais sobre consciência de IA

O embate sobre “consciência” e “bem-estar” de IA vai crescer conforme agentes digitais fiquem mais convincentes. Suleyman defende um realinhamento pragmático: IA construída para pessoas, com foco em utilidade e segurança. Em paralelo, uma parte da comunidade científica pede investigação séria sobre estados subjetivos em modelos, sem abandonar a proteção dos usuários. O rumo desse debate de consciência de IA moldará produto, política e percepção pública de IA nos próximos anos.