Gemini 2.5 Flash: versão prévia mais rápida e eficiente

Google lançou hoje, 25/09/2025, versões prévias do Gemini 2.5 Flash e do Gemini 2.5 Flash-Lite no Google AI Studio e no Vertex AI, com foco em mais qualidade e eficiência. As novidades incluem respostas mais concisas, melhor uso de ferramentas em aplicações “agentic” e ganhos claros em custo/latência.

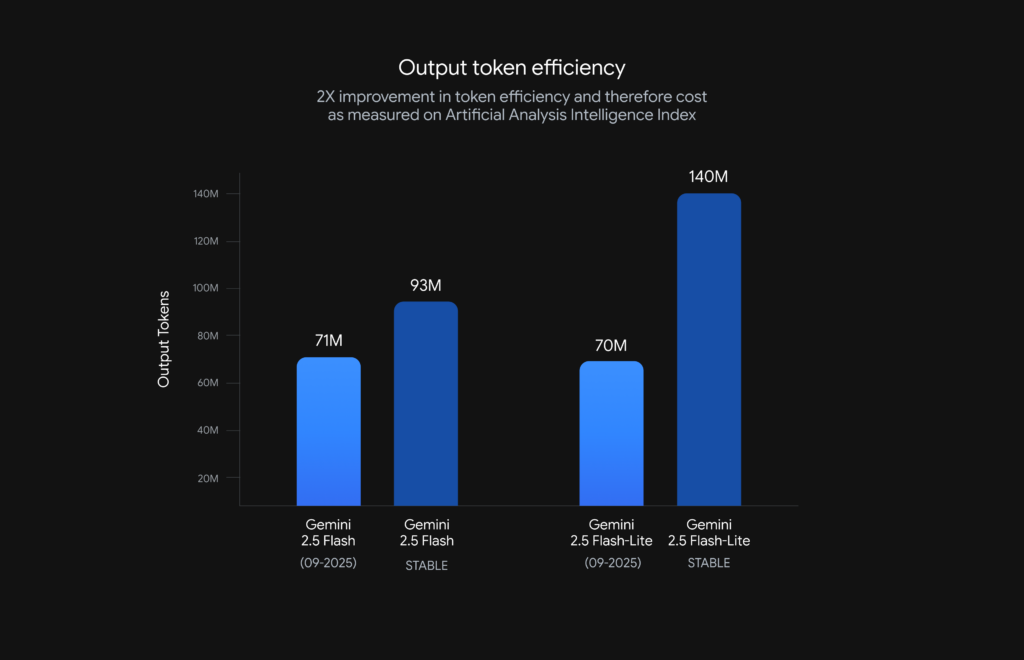

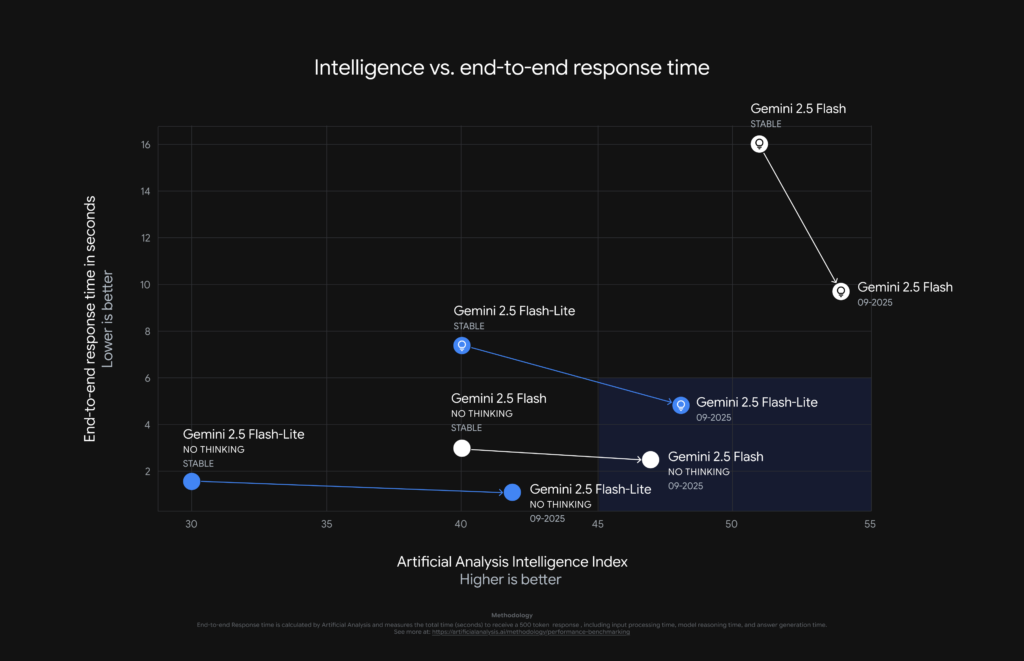

Segundo o Google, houve redução de 50% nos tokens de saída no Flash-Lite e 24% no Flash, além de melhorias de velocidade e um salto de 48,9% para 54% no benchmark SWE-Bench Verified. Os modelos podem ser testados com as strings: “gemini-2.5-flash-preview-09-2025” e “gemini-2.5-flash-lite-preview-09-2025”.

Tabela de conteúdos

O que muda no Gemini 2.5 Flash-Lite

A nova iteração do Gemini 2.5 Flash-Lite foi treinada em três frentes principais: (1) seguimento de instruções mais fiel, inclusive a prompts de sistema complexos; (2) menor verbosidade, que reduz custos (menos tokens) e latência em workloads de alto volume; e (3) recursos multimodais/idiomas mais robustos, com melhor transcrição de áudio, entendimento de imagens e qualidade de tradução. Para iniciar testes, utilize a string de modelo gemini-2.5-flash-lite-preview-09-2025.

- Instruções: maior aderência a comandos e políticas.

- Verbosidade: respostas mais objetivas e custo por requisição menor.

- Multimodal: ganhos em áudio, visão e tradução.

- Pontos-chave: menor custo por resposta; latência reduzida; melhor cobertura de idiomas e modalidades.

Novidades no Gemini 2.5 Flash

No Gemini 2.5 Flash, o foco recaiu sobre uso “agentic” de ferramentas e eficiência com o “thinking” ativado. Em cenários de múltiplas etapas e orquestração de ferramentas, o modelo passou a selecionar e encadear melhor ações, o que se refletiu em +5 p.p. no SWE-Bench Verified (de 48,9% para 54%) em relação ao release anterior. Além disso, com o “thinking” ligado, o modelo mantém qualidade alta usando menos tokens, o que reduz latência e custo.

“O novo Gemini 2.5 Flash oferece um notável equilíbrio entre velocidade e inteligência. Nossa avaliação interna mostrou um salto de 15% em tarefas agentic de longo horizonte. Sua eficiência de custo permite escalar a níveis inéditos.”

Yichao ‘Peak’ Ji, Co‑Fundador e Chief Scientist na Manus

- Pontos-chave: melhor coordenação de ferramentas; ganhos mensuráveis em benchmarks; economia de tokens com “thinking”.

Resultados em custos, tokens e latência

Os gráficos compartilhados pelo Google indicam duas direções claras: (a) as prévias do Gemini 2.5 Flash e do Flash-Lite estão mais rápidas e (b) entregam respostas mais curtas sem perda de qualidade, reduzindo tokens de saída (custos). Embora preços, limites e recursos possam variar entre releases, a tendência apresentada é de melhor qualidade por token, algo valioso para chatbots de alto tráfego, agentes autônomos e pipelines que exigem latências previsíveis.

| Atributo | Gemini 2.5 Flash (prévia 09/2025) | Gemini 2.5 Flash-Lite (prévia 09/2025) |

| Tokens de saída | -24% (segundo o Google) | -50% (segundo o Google) |

| Uso de ferramentas | Melhora notável; +5 p.p. no SWE-Bench | — |

| Verbosidade | Redução com “thinking” eficiente | Respostas mais concisas por padrão |

| Multimodal/Tradução | Melhor entendimento de imagem | Áudio, visão e tradução mais precisos |

| Custo/latência | Mais eficiente com qualidade alta | Custos ainda mais baixos por requisição |

Como começar: AI Studio, Vertex e aliases “-latest”

As prévias podem ser testadas no AI Studio e no Vertex AI. O Google também introduziu um alias “-latest” para cada família de modelos, apontando sempre para a versão mais recente. Isso simplifica a experimentação sem precisar atualizar o código a cada release:

gemini-flash-latestgemini-flash-lite-latest

Importante: por serem aliases, limites, custos e recursos podem variar entre versões. O Google avisará com 2 semanas de antecedência por e‑mail antes de atualizar ou descontinuar uma versão atrás do “-latest”. Para aplicações que exigem estabilidade, recomenda-se manter gemini-2.5-flash e gemini-2.5-flash-lite estáveis até que novas versões graduem para o canal estável (documentação).

Casos de uso e implicações práticas

Para aplicações agentic — que planejam, chamam ferramentas/APIs e monitoram resultados —, o novo Flash tende a reduzir reiterações e “loops” improdutivos, encadeando melhor passos complexos. Em chatbots de suporte, a menor verbosidade ajuda a manter respostas diretas, baratas e rápidas, sem sacrificar precisão. Em cenários multimodais, o Flash-Lite ganha relevância quando a meta é transcrever áudio, interpretar imagens e traduzir com qualidade usando menos tokens. Em pipelines batch, os ganhos de custo/latência podem liberar orçamento para processar mais itens no mesmo SLA.

- Agentes de múltiplos passos com orquestração de ferramentas.

- Chatbots de alto volume com custo por sessão previsível.

- Análise multimodal leve: áudio, imagens e tradução.

- Rotinas batch e ETL com janelas de execução rígidas.

Transparência, limitações e metodologia

Este conteúdo resume e contextualiza o anúncio oficial do Google for Developers (25 set 2025). As métricas informadas (reduções de tokens, ganhos em benchmarks e gráficos de latência/qualidade) derivam das publicações do Google e podem variar por configuração, workload e código de integração. As versões de hoje são prévias e não visam, por ora, graduar para o canal estável; servem para coletar feedback e acelerar o amadurecimento dos próximos releases estáveis.

- Fontes primárias: anúncio no blog Google for Developers; documentação da API Gemini.

- Validação: números e citações fornecidos pelo Google e parceiros (Manus).

- Limitações: métricas podem mudar; aliases “-latest” sofrem ajustes.

Perguntas Frequentes sobre gemini-flash-latest

O que há de novo no Gemini 2.5 Flash-Lite?

Resposta direta: menos verbosidade, melhor instrução e multimodal. Expansão: a prévia melhora transcrição de áudio, visão e tradução, além de respostas mais objetivas para reduzir tokens e latência. Validação: números oficiais indicam -50% em tokens de saída.

Quais modelos usar para testar agora?

Resposta direta: use as strings de prévia. Expansão: gemini-2.5-flash-preview-09-2025 e gemini-2.5-flash-lite-preview-09-2025 no AI Studio e Vertex AI. Validação: conforme anúncio do Google (25/09/2025).

Como funciona o alias “-latest”?

Resposta direta: aponta sempre para a versão mais recente. Expansão: gemini-flash-latest e gemini-flash-lite-latest reduzem a necessidade de atualizar código a cada release. Validação: Google promete aviso por e‑mail com 2 semanas de antecedência.

As prévias são recomendadas para produção?

Resposta direta: apenas se você tolera variações. Expansão: como aliases e prévias podem mudar limites, custos e recursos, use os estáveis (gemini-2.5-flash/-lite) para máxima previsibilidade. Validação: orientação explícita na documentação estável da Gemini API.

Qual o ganho em benchmarks agentic?

Resposta direta: +5 p.p. no SWE-Bench Verified. Expansão: a taxa subiu de 48,9% para 54%, sugerindo melhor encadeamento de passos e uso de ferramentas. Validação: dados reportados pelo Google DeepMind no anúncio.

Considerações finais

O ciclo de prévias do Gemini 2.5 Flash e do Flash-Lite sinaliza um foco claro: mais qualidade por token, latência menor e melhor uso de ferramentas para cenários agentic. Para times que desejam antecipar a adoção de melhorias, os aliases “-latest” simplificam testes rápidos. Para quem busca estabilidade, as versões estáveis continuam o caminho seguro até o próximo ciclo de graduação. Em ambos os casos, os dados indicam que o ecossistema Gemini segue avançando em velocidade, custo e inteligência aplicada.