PokeeResearch-7B: agente open-source de pesquisa 7B

Pokee AI lançou, em 22 de outubro de 2025, o PokeeResearch-7B, um agente de deep research de 7B parâmetros, open-source, capaz de navegar pela web, recuperar evidências, auto-verificar respostas e operar localmente ou via vLLM. O projeto chega com código, pesos e paper, além de alegar resultado SOTA entre pares 7B em 10 benchmarks de pesquisa profunda. A seguir, detalhamos recursos, licenças, requisitos e como experimentar.

Tabela de conteúdos

O que é o PokeeResearch-7B e por que importa

O PokeeResearch-7B é um agente de pesquisa pensado para desenvolvedores e equipes de pesquisa que precisam gerar relatórios fundamentados, com citações e verificações cruzadas. Ele integra busca na web e leitura de conteúdo, abre threads paralelas de investigação, realiza self-checks e se recupera de erros de ferramentas. A proposta é padronizar workflows de pesquisa profunda tanto em ambientes locais quanto em opções hospedadas.

Como funciona: reforço com feedback de IA e raciocínio multi-chamada

Segundo a Pokee AI, o pipeline de treinamento usa aprendizado por reforço com feedback de IA para alinhar o agente a respostas factuais e raciocínio apoiado em ferramentas. A arquitetura de multi-call reasoning estrutura várias chamadas de raciocínio e consulta (por exemplo, ao mecanismo de busca, aos leitores de páginas e a verificadores), permitindo coleta de evidências e auto-verificação antes da resposta final. Essa abordagem tende a reduzir alucinações e a melhorar a confiança em tarefas de pesquisa aprofundada.

- Coleta e consolidação de evidências a partir de múltiplas fontes.

- Verificação cruzada e auto-checagem para mitigar erros factuais.

- Threads paralelas de pesquisa para cobrir ângulos complementares.

- Integração com busca na web e leitura de páginas.

- Suporte a ferramentas externas e recuperação de falhas.

Execução local e via vLLM: requisitos e aplicativos

O repositório inclui documentação de testes em NVIDIA A100 80GB e oferece uma CLI para uso no terminal e um aplicativo Gradio para demonstração visual. A compatibilidade com vLLM viabiliza inference eficiente, enquanto a opção local atende cenários com restrições de dados. A Pokee AI descreve também mecanismos de recuperação diante de erros de ferramentas, úteis quando um conector de busca falha ou um site não carrega.

| Modo | Vantagem | Cenário ideal |

| Local | Privacidade e controle | Dados sensíveis e auditoria |

| vLLM | Desempenho e escalabilidade | Consultas intensivas e latência |

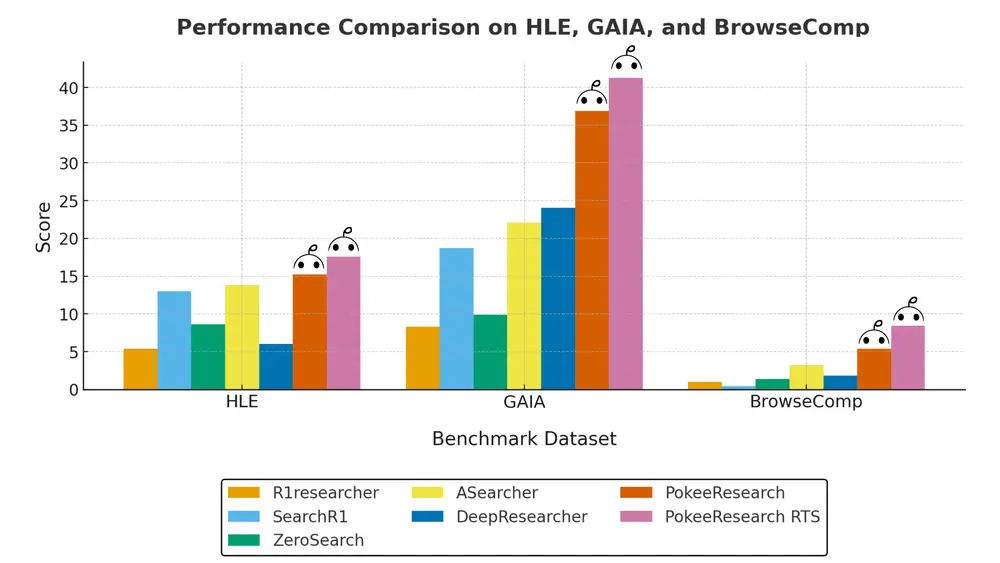

Desempenho: SOTA entre agentes 7B em 10 benchmarks

A equipe afirma que o PokeeResearch-7B alcança estado da arte (SOTA) entre agentes de 7B em 10 benchmarks focados em deep research. Embora nem todos os testes sejam detalhados publicamente, a reivindicação sugere ganhos de raciocínio estruturado, recuperação de informações e verificação quando comparados a outros modelos de porte similar.

“Open. Source. SOTA. Deep. Research.” — lançamento do PokeeResearch-7B ressalta código e pesos abertos, foco em pesquisa profunda e desempenho de ponta entre agentes 7B.

Pokee AI

Licenças e repositório: Apache-2.0 no código, MIT no paper

Segundo a publicação, o repositório do projeto está sob Apache-2.0, enquanto o paper menciona MIT. Essa discrepância indica que os termos finais podem estar em ajuste. Para uso comercial ou redistribuição, recomenda-se verificar o arquivo de licença no repositório e eventuais comunicados subsequentes da Pokee AI.

Para quem é: engenheiros, analistas e startups

O público-alvo inclui engenheiros, analistas e startups que exigem relatórios com citações, respostas rastreáveis e processos auditáveis. Em pipelines corporativos, o modelo pode agregar fontes públicas e internas, citar trechos relevantes e produzir saídas verificáveis para revisão humana. Em pesquisa acadêmica, a promessa é acelerar levantamentos bibliográficos e revisões de literatura com melhor governança de evidências.

Como experimentar agora

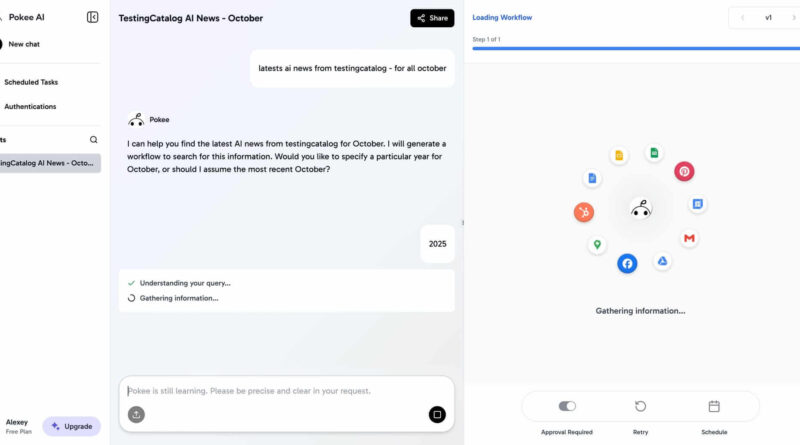

A Pokee AI oferece um preview de API de Deep Research hospedada, divulgada como mais econômica que alternativas existentes. Para testes locais, o repositório inclui CLI, app Gradio e instruções para vLLM, além de exemplos de configuração.

Anúncio oficial no X (Twitter)

Pontos-chave

- Open-source 7B com pesos e código disponíveis.

- Deep research com evidências e auto-verificação.

- Operação local ou via vLLM.

- Ferramentas: CLI, Gradio, integração web.

- Alegação de SOTA em 10 benchmarks.

Comparativo: local vs hospedado

| Critério | Local | Hospedado/API |

| Privacidade | Máxima (dados in-house) | Dependente do provedor |

| Latência | Baixa (hardware adequado) | Variável (rede/escala) |

| Custo | CapEx (GPU) + Manutenção | OpEx (uso sob demanda) |

| Escala | Limitada ao cluster | Elástica no provedor |

Boas práticas para adoção

- Defina objetivos de pesquisa (escopo, fontes, KPIs de precisão).

- Estabeleça governança (revisão humana, registro de evidências e citações).

- Valide hardware (GPU/HBM), latência e custo por consulta.

- Teste em amostras reais e crie playbooks por domínio.

- Monitore qualidade: taxa de citações válidas e retratações.

“Fundar um agente em evidências e verificação reduz alucinações e acelera a produção de relatórios confiáveis.”

Equipe editorial

O que diferencia o PokeeResearch-7B de outros agentes 7B?

Resposta direta: foco em deep research com evidências e auto-verificação. Expansão: o agente combina busca na web, leitura de conteúdo, threads paralelas e um arranjo de multi-call reasoning para coletar e validar fontes, reduzindo alucinações. Validação: repositório open-source e anúncio oficial destacam SOTA em 10 benchmarks.

Quais os requisitos para rodar localmente ou via vLLM?

Resposta direta: GPU robusta e stack compatível com vLLM. Expansão: a documentação cita testes em NVIDIA A100 80GB, CLI e app Gradio; ambientes menores podem funcionar com ajuste de contexto e lotes. Validação: verifique o README e as notas de desempenho do repositório.

Como funciona a auto-verificação para reduzir alucinações?

Resposta direta: checagens internas e cruzamento de evidências. Expansão: o agente executa chamadas de busca/leitura, agrega trechos relevantes, compara consistência e rejeita respostas sem respaldo. Validação: o paper descreve reforço com feedback de IA e scaffold de raciocínio multi-chamada.

A licença é Apache-2.0 ou MIT, afinal?

Resposta direta: há menções a ambas; confirme no repo. Expansão: o código é listado como Apache-2.0, enquanto o paper cita MIT; até atualização oficial, trate a política como em revisão. Validação: consulte o arquivo LICENSE e comunicados da Pokee AI.

Quem deve usar e quais casos de uso ideais?

Resposta direta: engenheiros, analistas e startups. Expansão: geração de relatórios com citações, análises competitivas, revisões de literatura e due diligence com rastreabilidade. Validação: a página de API de Deep Research e o anúncio descrevem esses perfis.

Considerações finais

Com código e pesos abertos, foco em evidências e auto-verificação, o PokeeResearch-7B se posiciona como um dos agentes 7B mais ambiciosos para deep research. A combinação de execução local e vLLM, suporte a CLI/Gradio e uma API hospedada facilita pilotos rápidos e integrações. Antes de produção, avalie licenciamento, custos e métricas de qualidade com seus próprios dados. Se cumprir o que promete, a Pokee AI dá um passo relevante para padronizar workflows de pesquisa mais confiáveis.

Fonte: anúncio da Pokee AI e cobertura do TestingCatalog. Link para teste: pokee.ai/workflow-agent.