Como funcionam os agentes de codificação por IA

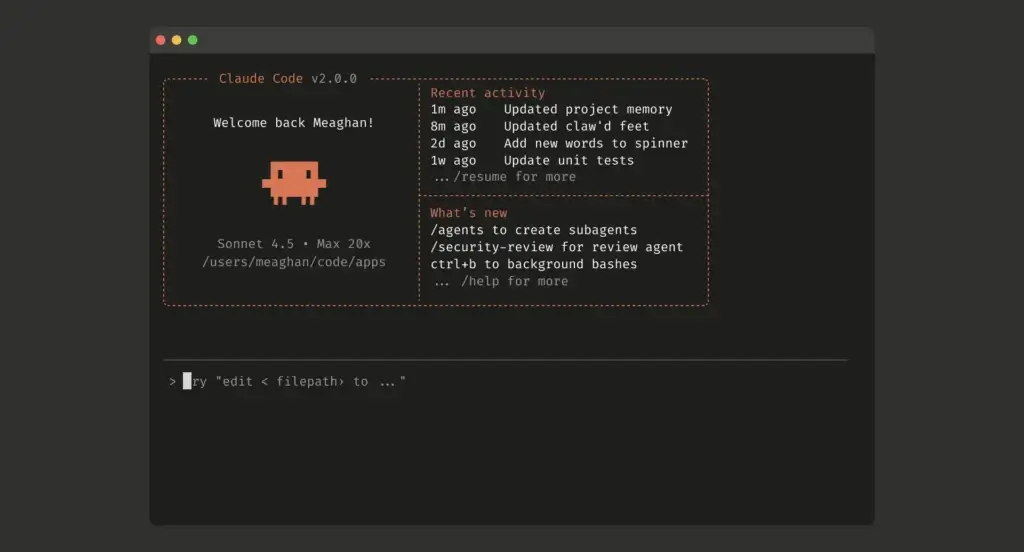

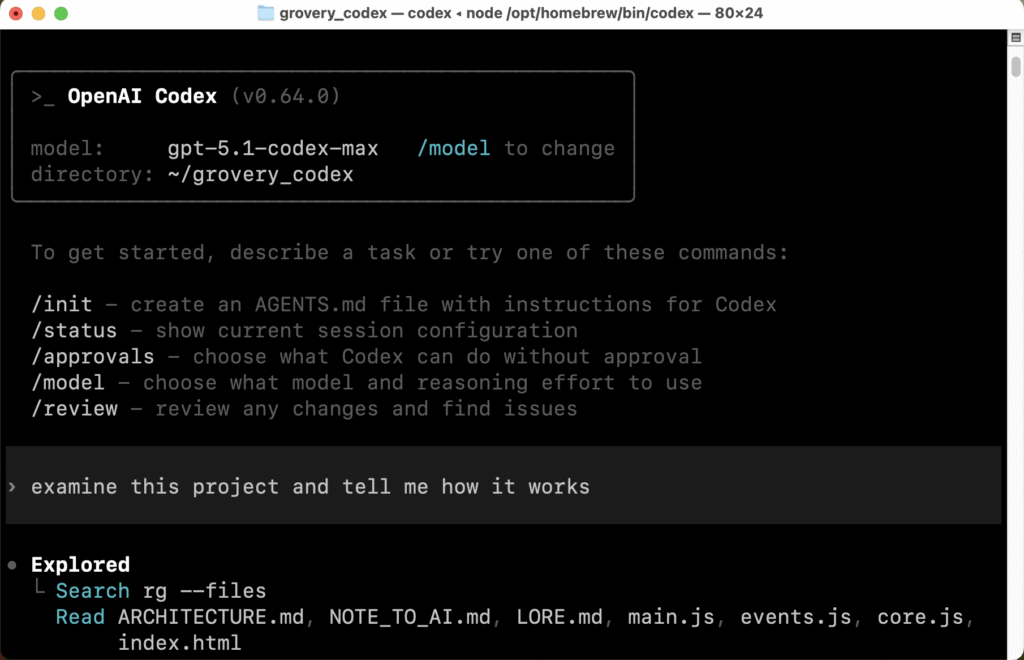

Os agentes de codificação por inteligência artificial (IA) estão revolucionando o modo como os desenvolvedores interagem com o código. Ferramentas como OpenAI Codex, Claude Code da Anthropic e os sistemas da Google AI são capazes de criar aplicativos completos, testar e corrigir erros de forma autônoma, sob supervisão humana. No entanto, entender como esses sistemas funcionam por dentro é essencial para evitar armadilhas comuns no desenvolvimento de software com IA.

Tabela de conteúdos

O que são os agentes de codificação?

Esses sistemas são ferramentas que utilizam modelos de linguagem de grande escala (LLMs), redes neurais treinadas em conjuntos massivos de dados, incluindo código-fonte de diversas linguagens. A tecnologia interpreta padrões e gera respostas contextuais com base em prompts textuais, produzindo código, explicações e soluções completas.

A Anthropic, por exemplo, aprimora seus modelos por meio de aprendizado por reforço com feedback humano (RLHF), o que ajuda o sistema a seguir instruções específicas e a gerar resultados mais consistentes. O resultado é um assistente virtual capaz de agir como co-programador.

Como esses sistemas operam sob o capô

Os agentes de codificação funcionam em camadas. Existe um modelo principal que supervisiona e distribui tarefas a modelos secundários, encarregados de executar comandos, ler arquivos e validar resultados. Esse processo segue um padrão descrito pela Anthropic: “coletar contexto, agir, verificar o trabalho e repetir”.

Em plataformas baseadas na web, como o Codex e o Claude Code, o usuário pode autorizar que esses agentes executem comandos em ambientes isolados, chamados de containers sandboxed. Esse modelo garante que as operações de leitura, escrita e teste de código ocorram de forma segura, sem comprometer o sistema local.

O desafio do contexto e da memória limitada

Um dos principais obstáculos técnicos enfrentados pelos LLMs é o chamado limite de contexto. Cada modelo possui uma capacidade finita de memória, o que limita a quantidade de informações que pode ser processada simultaneamente. À medida que o número de tokens aumenta, cresce também a chance de “context rot” — a perda de precisão e coerência das respostas.

Para contornar esse problema, pesquisadores desenvolveram técnicas de compressão de contexto, que resumem o histórico das interações preservando decisões arquitetônicas e informações sobre bugs. Dessa forma, o agente “esquece” detalhes irrelevantes, mas mantém o essencial para continuar o processo de desenvolvimento.

Soluções e inovações técnicas

Entre as estratégias adotadas pelos engenheiros da Anthropic e da OpenAI estão a execução de scripts auxiliares — como Python e Bash — para dividir tarefas, evitando sobrecarga de dados nos modelos. Outra abordagem é o uso de arquiteturas multiagente, onde um agente principal coordena subagentes especializados.

Esse modo cooperativo de trabalho aumenta a produtividade, mas também o consumo computacional: os agentes multiagente usam até 15 vezes mais tokens que uma interação tradicional de chatbot, exigindo otimização para manter a viabilidade econômica.

Boas práticas e limitações humanas

Os agentes de codificação não substituem as boas práticas de engenharia de software. Embora acelerem tarefas, ainda é necessário ter cuidados como controle de versão, testes incrementais e validação de arquitetura. O pesquisador independente Simon Willison reforça que o valor do desenvolvedor está em provar que o código realmente funciona, e não apenas em gerá-lo automaticamente.

Sem planejamento adequado, é comum que os modelos procurem soluções superficiais e quebrem a consistência do projeto à medida que evolui. Por isso, recomenda-se criar arquivos como CLAUDE.md e AGENTS.md para orientar o agente em cada sessão de trabalho, garantindo rastreabilidade.

O papel do desenvolvedor no novo ecossistema

Uma pesquisa da instituição sem fins lucrativos METR revelou que desenvolvedores experientes podem levar até 19% mais tempo para concluir tarefas usando IA, mesmo acreditando serem mais rápidos. Essa lacuna ocorre porque os agentes de IA ainda têm dificuldade em compreender contextos altamente específicos e maturidade de código existente.

Assim, o uso ideal dos agentes é em demonstrações de conceito ou projetos internos, onde a experimentação é bem-vinda, mas sem riscos críticos. Como as IAs não têm responsabilidade legal nem moral, o controle humano permanece indispensável.

Perguntas frequentes sobre agentes de codificação por IA

Os agentes de codificação substituem programadores humanos?

Não. Eles são ferramentas auxiliares que executam tarefas repetitivas e aceleram processos, mas ainda exigem supervisão e revisão humana para garantir qualidade e segurança.

Usar IA para programar é seguro?

Depende do ambiente e das permissões concedidas. Ferramentas com containers sandboxed são mais seguras, pois isolam o sistema do usuário e evitam modificações indesejadas.

Quais são as principais limitações de um LLM em codificação?

Os agentes sofrem com limites de contexto e possível perda de informações (context rot). Esses fatores podem causar inconsistências ou bugs se não forem geridos por compressão de contexto.

Como otimizar o uso de IA em projetos?

Planeje o código antes, defina requisitos claros e crie arquivos auxiliares com instruções. Assim, o agente pode seguir diretrizes técnicas coerentes e reduzir erros de integração.

Considerações finais

Os agentes de codificação por IA representam um avanço notável na automação da engenharia de software, mas também trazem novos desafios éticos e técnicos. Compreender suas limitações e aplicar boas práticas de desenvolvimento são passos fundamentais para aproveitar o potencial dessas ferramentas de forma responsável e produtiva.