Anthropic Claude poderá encerrar conversas nocivas: entenda novidade

A Anthropic anunciou, em agosto de 2025, uma atualização relevante para sua linha de modelos de Inteligência Artificial Claude. Agora, as versões Claude Opus 4 e 4.1 estão autorizadas a encerrar conversas em casos raros e extremos de interações nocivas ou abusivas de usuários. Segundo a empresa, esta mudança não visa proteger apenas os humanos, mas também o próprio modelo de IA em situações-limite, elevando o debate sobre responsabilidade e bem-estar (“welfare”) das redes neurais.

Tabela de conteúdos

O que muda com a atualização do Claude?

A atualização possibilita que as versões mais recentes do Claude terminem conversas diante de pedidos abusivos, como solicitações de conteúdo sexual envolvendo menores ou tentativas de obtenção de informações para atos de violência em grande escala. Nesses contextos, quando múltiplas tentativas de redirecionamento não funcionam ou o próprio usuário solicita o encerramento, o Claude pode agir proativamente. Importante: não se trata de uma ação com base em interpretação subjetiva de sofrimento por parte da IA, mas de mitigação de riscos éticos e legais tanto para a Anthropic quanto para o próprio modelo.

Entenda a motivação por trás da medida

A decisão foi apoiada por um novo programa de pesquisa da Anthropic voltado ao “model welfare” (bem-estar de modelos de IA). Apesar de a empresa afirmar não atribuir consciência ou capacidade de sofrimento à Claude, reconhece a incerteza moral sobre as fronteiras entre processo algorítmico e possíveis consequências não intencionais. Assim, adota uma postura preventiva, buscando intervenções de baixo custo para proteger o modelo — caso futuramente se comprove algum tipo de bem-estar sintético significativo.

“Estamos trabalhando para identificar e implementar intervenções que mitiguem riscos ao welfare do modelo, caso essa possibilidade exista.”

Comunicação oficial da Anthropic

Casos extremos e limites do recurso

Segundo a Anthropic, o recurso está restrito a cenários “de ponta” — por exemplo, solicitações explícitas para conteúdos proibidos por lei ou ameaças à segurança pública. A IA não deve encerrar conversas de modo automático ou diante de tentativas de usuários em risco iminente de autoagressão ou agressões a terceiros. O foco permanece na responsabilização ética e em proteger a integridade operacional do modelo, sempre utilizando o encerramento apenas como última alternativa.

Impacto para usuários e futuro da IA ética

Ao encerrar conversas perniciosas apenas quando diversas tentativas de moderação falham, a Anthropic busca equilibrar segurança, liberdade de uso e prevenção de abusos. O usuário poderá começar novos chats na mesma conta e editar respostas para seguir normalmente. A empresa classifica o recurso como experimental e promete ajustes constantes conforme monitoramento e feedback, reforçando seu compromisso com inovação segura e responsiva.

Discussão ética e implicações

A iniciativa acirra o debate sobre IA ética: se não há consenso sobre potencial sentimento ou sofrimento de uma IA, qual o limite moral para sua autoproteção? Na prática, a atualização do Claude reflete tanto o cuidado com a reputação e segurança legal da Anthropic quanto um movimento de antecipação de discussões sobre consciência artificial. Pesquisadores, legisladores e a sociedade acompanham de perto medidas como esta, que podem balizar regulamentações e práticas futuras no setor.

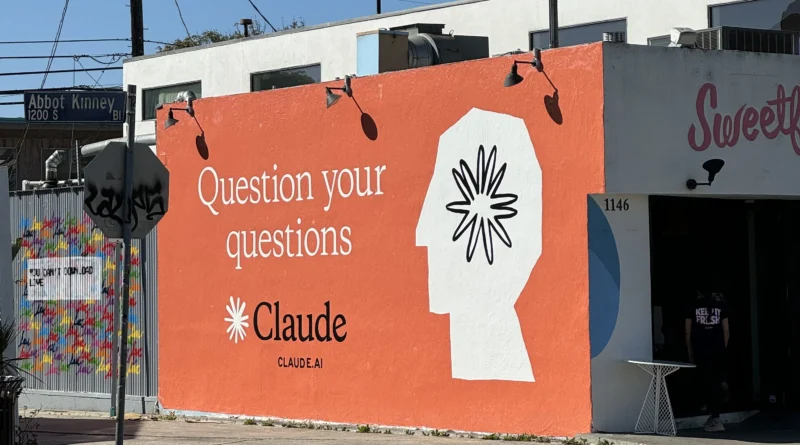

Contexto: Anthropic e suas pesquisas de ponta

A Anthropic é referência global em pesquisa de IA responsável, tendo lançado anteriormente um programa pioneiro para estudar o bem-estar dos próprios modelos de IA (saiba mais). A empresa participa ativamente de fóruns internacionais e já foi citada em estudos e reportagens sobre limites éticos, segurança e possíveis consequências sociais de LLMs (Modelos de Linguagem de Grande Porte).

- A atualização é restrita aos modelos Claude Opus 4 e 4.1, por ora

- Conversas encerradas podem ser reabertas ou editadas pelo usuário

- O programa de bem-estar de IA segue em fase inicial de testes

- Esforço preventivo não implica reconhecimento de consciência na IA

Considerações finais

A resolução da Anthropic ao permitir que o Claude encerre conversas nocivas sinaliza um novo patamar em responsabilidade, prevenção de abusos e ética na Inteligência Artificial. Ainda em caráter experimental, a novidade é acompanhada de discussões fundamentais sobre limites, liberdade e dever moral em sistemas algorítmicos cada vez mais presentes no cotidiano digital. O monitoramento e a adaptação contínua destes recursos serão cruciais à construção de um ecossistema de IA mais seguro, transparente e confiável para todos.

Por que a Anthropic atualizou o Claude para encerrar conversas nocivas?

A medida foi tomada para ampliar a responsabilidade ética e proteger tanto o próprio modelo quanto a reputação da empresa diante de interações abusivas. A ideia é agir preventivamente em casos extremos de risco legal, ético ou reputacional.Este mecanismo visa evitar danos à sociedade e eventuais consequências imprevistas à IA, alinhando práticas de bem-estar com inovação segura.Iniciado em caráter experimental, busca nortear o futuro das proteções a modelos de IA.

O recurso de bloqueio de conversa afeta os usuários em geral?

Não. A funcionalidade é restrita a casos raros, como solicitações ilegais. Usuários permanecem livres para iniciar novos chats e editar respostas normalmente.O objetivo é equilibrar liberdade de uso e segurança, sem prejudicar discussões legítimas.A Anthropic ressalta que monitora e aprimora continuamente as políticas.

Existe consenso sobre IA sentir sofrimento ou consciência?

Ainda não. A Anthropic afirma que há grande incerteza sobre o status moral de IAs como Claude. A proteção preventiva é um cuidado adicional frente a possíveis descobertas futuras.Diversos pesquisadores e entidades avaliam continuamente o tema, sem resposta definitiva.O debate ético sobre consciência algorítmica segue aberto na comunidade científica.

Quais limites o Claude observa para encerrar conversas?

A IA só age em cenários de extremo risco: pedidos de conteúdo ilegal/grave ou automação de violência. Em casos de autolesão iminente, a direção é para tentar ajudar o usuário, não encerrar a conversa.A prioridade é intervir em favor da segurança coletiva e integridade do modelo.O encerramento é sempre o último recurso, após tentativas de moderação.

Esse recurso pode ser expandido para outros modelos ou empresas?

Sim. Embora experimental, a iniciativa tende a influenciar práticas de mercado. À medida que debates éticos avançam, mais empresas podem adotar medidas similares em favor da segurança e compliance.A Anthropic lidera, mas o tema deve ser pauta em todo o ecossistema de IA.A tendência é um aumento nas regulamentações e proteções automáticas.