Bots na internet: maioria do tráfego já em 2024

Imperva aponta que bots já respondem por mais de 50% do tráfego global da internet em 2024, após saltarem de 42,3% (2021) para 49,6% (2023). Em menos de três anos, especialistas projetam que o número de interações automatizadas deve superar com folga o de humanos ativos. A aceleração vem da IA, que torna esses agentes mais sofisticados, escaláveis e difíceis de detectar. Somado a isso, cresce a dependência de conteúdo sintético para treinar modelos, enquanto o link rot apaga registros humanos: 38% do material publicado em 2013 já não está acessível, segundo o Pew Research Center. O resultado: uma web mais rápida — e potencialmente mais artificial.

Tabela de conteúdos

O que os números mostram agora dos bots na internet

O Imperva Bad Bot Report 2025 indica uma inflexão histórica. Em 2021, os bots representavam 42,3% do tráfego global; em 2023, 49,6%; e, em 2024, passaram a maioria. O avanço é impulsionado por scrapers, automações comerciais, account takeovers, spam em massa e, mais recentemente, por agentes de IA que operam em velocidade e volume antes impraticáveis.

| Ano | Participação de bots | Fonte |

| 2021 | 42,3% | Imperva |

| 2023 | 49,6% | Imperva |

| 2024 | >50% | Imperva |

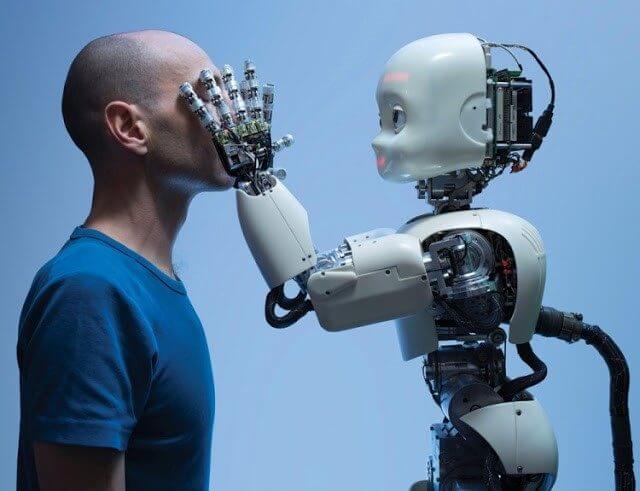

A teoria da “internet morta” deixa o meme e vira alerta

Surgida em 2021, a teoria da “internet morta” imaginava uma web dominada por bots e conteúdos artificiais. O que soava distópico hoje ganha contornos concretos. Pesquisadores como Jake Renzella e Vlada Rozova argumentam que a rede “de humanos, para humanos” vem sendo substituída por um ecossistema onde a maior parte das interações e publicações já não tem origem humana. Até mesmo líderes de empresas de IA admitem a virada.

Há muitas contas no Twitter operadas por modelos de linguagem.

Sam Altman, CEO da OpenAI

O fenômeno de bots na internet se agrava com o link rot — links que quebram, sites que saem do ar, conteúdos removidos. O Pew Research Center estima que 38% do conteúdo humano publicado em 2013 já desapareceu. Menos material verificado e mais automação formam um caldo perfeito para distorções, desinformação e retroalimentação de erros por modelos treinados com dados contaminados.

Da escassez de dados reais ao boom sintético

O setor de IA enfrenta um gargalo: o estoque de dados humanos de alta qualidade na web está perto do limite. Elon Musk já alertou para a escassez, e a resposta da indústria tem sido ampliar o uso de dados sintetizados por modelos. A consultoria Gartner estimou que, em 2024, 60% dos dados usados em projetos de IA eram artificiais. Um exemplo: o modelo Palmyra X 004 foi treinado com dados sintéticos a um custo de cerca de US$ 70 mil — contra uma estimativa de US$ 4,6 milhões se o treinamento equivalente fosse feito com dados humanos licenciados.

| Cenário | Tipo de dado | Custo estimado | Exemplo/Fonte |

| Treino sintético | Gerado por IA | ~US$ 70 mil | Palmyra X 004 |

| Treino com dados reais | Humano/licenciado | ~US$ 4,6 milhões | Estimativa setorial |

Riscos imediatos dos bots na internet: fraude, SEO e desinformação

Com bots dominando o tráfego, cresce o número de golpes de credential stuffing, ataques a formulários, clonagem de páginas para captura de dados e geração automática de reviews falsos. No jornalismo e no SEO, proliferam conteúdos “de fazenda” escritos por modelos e redesenhados para enganar mecanismos de busca e plataformas de anúncios. Para a sociedade, o risco é uma economia da atenção ainda mais vulnerável a campanhas coordenadas e a um ciclo de informação sintética retroalimentada.

- Fraude e account takeover mais baratos e escaláveis;

- SPAM e scraping agressivo com IA generativa;

- Poluição informacional e mais “alucinações” em IAs;

- Queda da diversidade de fontes e do registro histórico;

- Impactos na mensuração de audiência, conversão e brand safety.

Como mitigar: práticas para sites e equipes

Não há bala de prata, mas combinar camadas técnicas e editoriais diminui o impacto. Para operações digitais, vale investir em bot management com verificação comportamental, limitação por reputação, honeypots e desafiar automações com proof-of-work leve. Em conteúdo, adote transparência (sinalizar uso de IA), auditoria periódica, curadoria humana e metadados de procedência (C2PA). Para dados, garanta amostras de validação livres de contaminação sintética.

- Configurar WAF com regras específicas para scrapers;

- Monitorar anomalias de tráfego e assinaturas de botnet;

- Implantar política editorial de origem e revisão de conteúdo;

- Usar watermarking e hashing para ativos críticos;

- Mensurar KPIs com filtros anti-bot e server-side tracking.

Validação, fontes e limites do que sabemos

Os números citados vêm de fontes primárias e relatórios setoriais: Imperva (tráfego de bots), Pew Research (link rot) e Gartner (dados sintéticos). Atribuições sobre custo e metodologia de treinamentos refletem casos públicos e estimativas do mercado. Como em todo tema dinâmico de cibersegurança e IA, as métricas variam por amostragem, período e técnica de detecção — os percentuais devem ser lidos como tendências robustas, não como valores absolutos imutáveis.

- Fontes: Imperva, Pew Research Center, Gartner;

- Contexto: escassez de dados humanos e avanço da IA;

- Limitações: metodologias e períodos de medição distintos.

Bots já são maioria: o que isso significa?

Resposta direta: bots representam mais de 50% do tráfego. Expansão: isso indica que parcelas relevantes das visitas, cliques e requisições vêm de softwares automatizados, nem sempre maliciosos, mas difíceis de distinguir do humano. Validação: dados da Imperva mostram a inflexão em 2024.

O que é conteúdo sintético e por que importa?

Resposta direta: é dado gerado por IA, não por humanos. Expansão: textos, imagens e códigos criados por modelos servem para treinar novas IAs, reduzindo custos, mas podem reforçar vieses e erros. Validação: Gartner estima 60% de dados sintéticos em projetos de IA em 2024.

O que é link rot e como isso afeta a web?

Resposta direta: é o desaparecimento de conteúdos e links. Expansão: páginas saem do ar, URLs quebram e arquivos são removidos, apagando o registro humano e o material para treinar IAs. Validação: Pew Research calculou 38% de perda para conteúdos de 2013.

Como os sites podem mitigar o impacto dos bots?

Resposta direta: combine gestão de bots e curadoria humana. Expansão: WAF bem configurado, reputação, honeypots, monitoramento e políticas editoriais transparentes ajudam a reduzir tráfego falso e poluição. Validação: boas práticas recomendadas por fornecedores e equipes de segurança.

Isso muda a forma como buscamos informação?

Resposta direta: sim, a busca fica mais sensível a ruído. Expansão: mais páginas artificiais competem por ranking e modelos de IA podem reciclar dados sintéticos. Usuários devem checar fontes e datas. Validação: tendência observada em relatórios de mercado e equipes de SEO.

Considerações finais sobre bots na internet

Bots na internet não são novidade, mas a combinação de maioria de tráfego, escassez de dados humanos e boom sintético muda o jogo. Para empresas, a prioridade é proteger ativos e mensurar com precisão. Para o ecossistema de informação, o desafio é preservar qualidade, transparência e diversidade de fontes. A “internet pós-humana” pode ser útil e eficiente — desde que a automação seja auditável, e que a voz humana, com contexto e responsabilidade, continue definindo o que importa.