DeepSeek testa tokens visuais para memória de IA

A DeepSeek, empresa chinesa de inteligência artificial, está propondo substituir os tokens de texto por “tokens visuais” — imagens compactadas que armazenam informação textual — para ampliar a memória de modelos de linguagem (LLMs) e reduzir o context rot.

A abordagem que o DeepSeek testa tokens visuais, descrita em um estudo publicado no arXiv e validada em um novo sistema de OCR, promete reter praticamente o mesmo conteúdo usando menos tokens, barateando processamento e mantendo coerência em diálogos longos. O projeto tem código e pesos abertos no GitHub, o que facilita a reprodução por pesquisadores e equipes de produto.

Tabela de conteúdos

O método converte páginas em imagens compactadas e aplica compressão em camadas, preservando informação recente e “borrando” suavemente dados antigos para economizar tokens.

O que são “tokens visuais” e por que importam

LLMs tradicionais representam entradas como sequências de tokens de texto. Essa segmentação cresce rapidamente em conversas extensas e em documentos longos, elevando custo computacional e levando ao context rot — quando o modelo perde referências iniciais e a conversa fica menos coerente. Os tokens visuais da DeepSeek capturam trechos de texto como blocos de imagem comprimidos, permitindo condensar mais informação por token. Em outras palavras, a “janela de contexto” efetiva aumenta sem aumentar proporcionalmente o número de tokens de texto.

O desenho inclui um esquema de compressão hierárquica: o conteúdo mais recente permanece nítido e detalhado; o mais antigo sofre um leve desfoque — ainda legível — para reduzir custo de armazenamento e atenção do modelo. A promessa é diminuir o desperdício de capacidade com tokens redundantes de texto e, ao mesmo tempo, manter recall de fatos relevantes ao longo do diálogo.

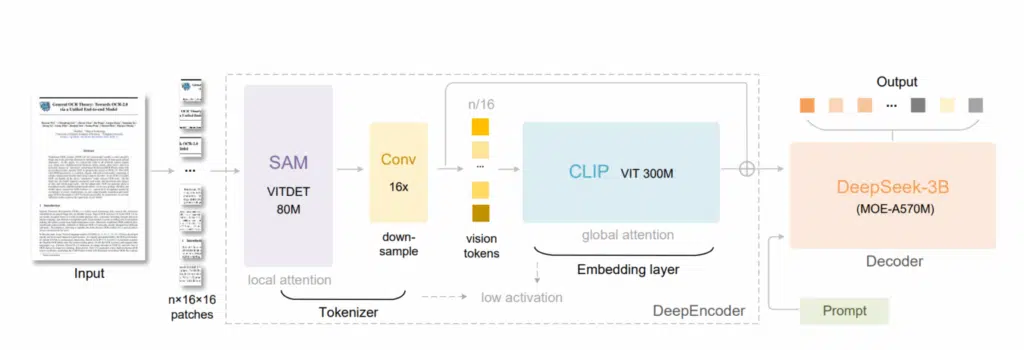

Como o método foi testado no OCR da DeepSeek

Para validar a ideia, a empresa treinou um modelo de Reconhecimento Óptico de Caracteres (OCR) no qual as páginas não são transcritas imediatamente para tokens de texto. Em vez disso, o sistema “tira uma foto” das páginas e trabalha com representações visuais compactadas. Resultados preliminares indicam que o modelo retém volume semelhante de informação com menos tokens. Segundo o artigo no arXiv, a abordagem melhora a eficiência sem derrubar a qualidade de extração de conteúdo.

- Entrada: páginas ou trechos longos convertidos em imagens compactadas;

- Codificação: compressão em camadas com priorização do conteúdo mais recente;

- Memória: quadros antigos passam por leve desfoque que preserva legibilidade;

- Saída: o modelo reconstrói e responde usando a memória visual como referência.

Além do ganho de contexto, há um benefício colateral relevante: síntese de dados de treinamento. O estudo informa que o pipeline do DeepSeek-OCR consegue gerar mais de 200 mil páginas por dia usando apenas uma GPU. Em uma fase de escassez de dados na web para treinar LLMs, esse throughput chama atenção do ecossistema.

Impacto no custo e na coerência de LLMs (context rot)

Representar informação textual como imagens tem duas consequências práticas. Primeiro, reduz o número de tokens processados a cada passo de inferência, o que diminui latência e custo. Segundo, aumenta a capacidade de “lembrar” trechos antigos sem precisar truncar agressivamente a conversa. Com isso, casos comuns de “perda de tópico” e respostas contraditórias ficam menos frequentes, especialmente em sessões com múltiplas iterações de perguntas e referências cruzadas.

Naturalmente, a técnica não elimina limitações fundamentais de atenção em janelas muito grandes, mas tenta distribuir os recursos de forma mais inteligente: detalhes recentes em alta resolução, histórico distante com compressão graduada. Esse trade-off mira tarefas de assistentes, agentes que leem PDFs longos e fluxos de suporte que exigem continuidade semântica.

Tokens de texto podem ser ineficientes na entrada; representações visuais podem, em última análise, ser melhores para LLMs.

Andrej Karpathy, em publicação no X/Twitter, sobre o estudo

DeepSeek testa tokens visuais: Repercussão e validação externa

A proposta ganhou elogios públicos de pesquisadores e engenheiros proeminentes. Andrej Karpathy, ex-Tesla e cofundador da OpenAI, destacou a ineficiência de tokens textuais na “entrada” de LLMs e considerou que imagens poderiam ser superiores em certas etapas. Já Manling Li, professora assistente de ciência da computação na Northwestern University, afirmou à MIT Technology Review que a ideia em si não é inédita, mas é “o primeiro estudo que leva o conceito tão longe e demonstra que pode funcionar de fato”.

Limitações atuais e próximos passos de pesquisa

Os próprios autores e especialistas alertam que a solução ainda é um primeiro passo. A principal limitação citada por Li é o tratamento linear da memória, em que o mais recente sempre recebe prioridade. Trabalhos futuros devem explorar um esquecimento dinâmico, que preserve eventos raros, importantes e distantes no tempo, enquanto descarta detalhes triviais. Em termos práticos, modelos poderiam “lembrar” um fato marcante de anos atrás, mas ignorar uma irrelevância de minutos atrás.

| Aspecto | Benefício | Limitação |

|---|---|---|

| Memória | Mais conteúdo por token; menos truncamento | Enfoque linear; precisa de esquemas dinâmicos |

| Custo | Menos tokens processados por passo | Compressão pode perder detalhes finos |

| Dados | Geração de 200k páginas/dia em 1 GPU | Generalização além de OCR ainda em estudo |

DeepSeek testa tokens visuais: Código aberto, reprodução e como explorar

Interessados podem consultar o artigo técnico no arXiv e baixar código e pesos no GitHub (DeepSeek-OCR). O repositório documenta requisitos de ambiente, instruções de inferência e exemplos de uso. Para avaliação comparável, é recomendável usar as mesmas configurações de compressão visual e medir custo/latência versus um baseline textual com janela de contexto equivalente.

- Leia o paper para entender o pipeline de compressão visual e os trade-offs;

- Teste com lotes de documentos longos (PDFs, transcrições) e compare custos;

- Avalie coerência de longo prazo em diálogos multi-turn com referências antigas;

- Monitore perdas de detalhe em tabelas, fórmulas e rodapés com tipografia fina.

Tokens visuais (definição objetiva)

Representações de texto como imagens compactadas, usadas como unidades de entrada em LLMs multimodais. Objetivo: reduzir contagem de tokens e manter coerência em janelas extensas.

Contexto: a trajetória recente da DeepSeek

A companhia já havia surpreendido o setor com o DeepSeek-R1, que alcançou benchmarks competitivos empregando menos recursos. Isso reforçou a percepção de que a empresa explora com habilidade engenharia de eficiência — soluções que entregam performance com custo reduzido. Tokens visuais se encaixam nessa filosofia ao atacar dois gargalos: custo por token e janela de contexto.

Perguntas Frequentes sobre DeepSeek testa tokens visuais

O que é context rot em LLMs?

Resposta direta: perda de coerência por histórico longo. Expansão: quando a conversa cresce, a janela de contexto fica saturada e o modelo esquece o início ou mistura tópicos. Tokens visuais tentam mitigar isso ao condensar informação e preservar referências antigas. Validação: descrito no paper da DeepSeek e discutido por especialistas como Karpathy.

Como funcionam os tokens visuais da DeepSeek?

Resposta direta: texto vira imagem compactada. Expansão: o sistema fotografa páginas, aplica compressão em camadas e prioriza conteúdo recente, mantendo dados antigos legíveis com leve desfoque. Isso reduz tokens e custo sem derrubar a utilidade. Validação: detalhes no arXiv e código no GitHub do DeepSeek-OCR.

Quais os benefícios e limites dessa abordagem?

Resposta direta: mais memória com menos tokens. Expansão: melhora a coerência em sessões longas e reduz latência/custo por passo, mas ainda trata memória de modo linear e pode perder detalhes finos ao comprimir. Validação: avaliação inicial em OCR; generalização a tarefas amplas está em estudo.

Posso testar o DeepSeek-OCR hoje?

Resposta direta: sim, é open-source. Expansão: o repositório no GitHub fornece pesos, instruções e exemplos para rodar inferência e medir eficiência com sua pilha. Validação: consulte o README e a documentação de ambiente publicada pela equipe.

Isso substitui completamente tokens de texto?

Resposta direta: não, por enquanto. Expansão: a proposta mostra ganhos promissores, mas integra-se a pipelines multimodais e ainda precisa de testes amplos em chat, agentes e RAG. Validação: especialistas como Manling Li apontam próximos passos como esquemas de esquecimento dinâmico.

Considerações finais do DeepSeek testa tokens visuais

Ao transformar texto em imagens compactadas, a DeepSeek avança uma trilha pragmática para ampliar a memória de LLMs e conter o context rot. As evidências iniciais no OCR e o entusiasmo de nomes como Karpathy sugerem potencial concreto, especialmente em cenários de documentos longos e fluxos com múltiplas iterações.

Ainda assim, o método precisa evoluir para um esquecimento mais inteligente, que priorize episódios raros porém críticos. Com paper e código abertos, o ecossistema tem agora meios de reproduzir, auditar e tensionar a proposta em aplicações reais — um passo importante para IAs mais úteis, coerentes e acessíveis.