Gemma 3n: guia completo para desenvolvedores

O Gemma 3n foi oficialmente lançado em 26 de junho de 2025. O novo modelo da Google chega como a terceira geração da família Gemma, trazendo IA multimodal de alto desempenho diretamente para dispositivos móveis. Desenvolvido por Omar Sanseviero e Ian Ballantyne, o 3n responde ao quem, o que, quando, onde, por que e como: é um modelo Google, lançado hoje, disponível globalmente, para acelerar a criação de aplicativos offline, eficientes e seguros.

Tabela de conteúdos

Com versões E2B (2 GB de memória) e E4B (3 GB), o Gemma 3n promete qualidade de modelos de nuvem de 2024 diretamente no seu smartphone ou micro-servidor. Nesta matéria você confere os avanços técnicos, resultados de benchmark, dicas de uso e oportunidades na Gemma 3n Impact Challenge.

O que muda na prática?

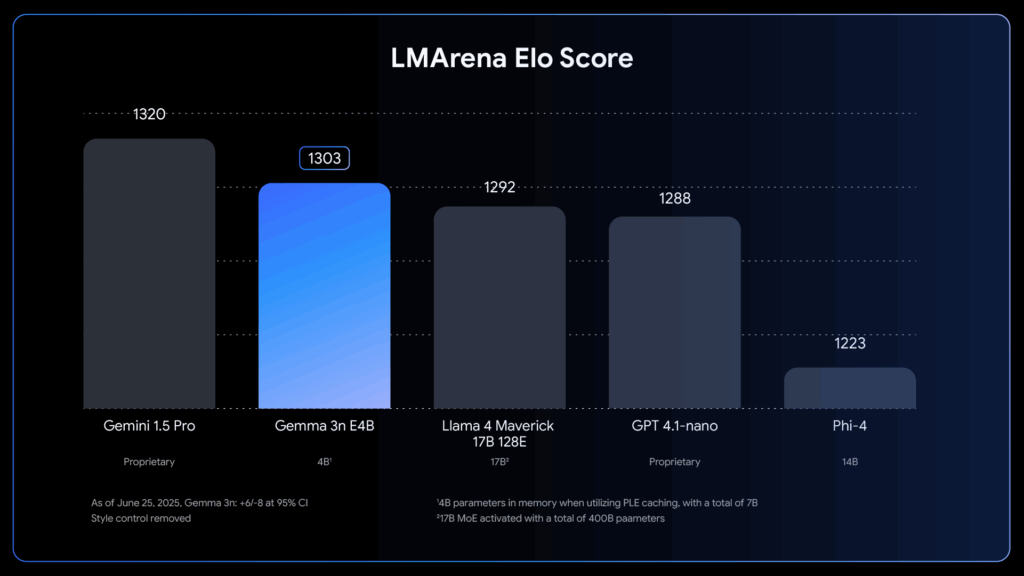

O salto geracional do 2n para o 3n concentra-se em quatro pilares: arquitetura MatFormer, Per-Layer Embeddings, KV Cache Sharing e encoders especializados para áudio e visão. Juntos, eles reduzem latência, consumo de memória e elevam a pontuação LMArena para mais de 1300 — recorde para modelos com menos de 10 bilhões de parâmetros.

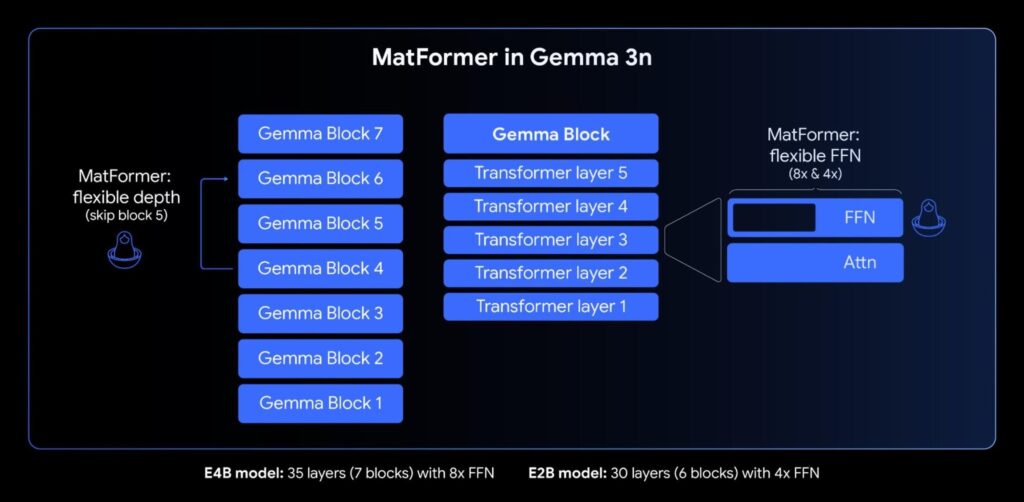

1. MatFormer: vários tamanhos em um único modelo

Inspirado em bonecas matryoshka, o MatFormer permite treinar um modelo grande que contém versões menores completamente funcionais. Durante o treinamento do Gemma 3n E4B (8B parâmetros brutos), um submodelo E2B é otimizado em paralelo. O resultado? Você faz download apenas do tamanho necessário ou cria variações personalizadas com a técnica Mix-n-Match.

- Modelos pré-extraídos: E2B (até 2× mais rápido) e E4B.

- Elasticidade futura: alternância dinâmica entre caminhos E2B/E4B.

- Ferramenta interativa: MatFormer Lab para gerar checkpoints ideais.

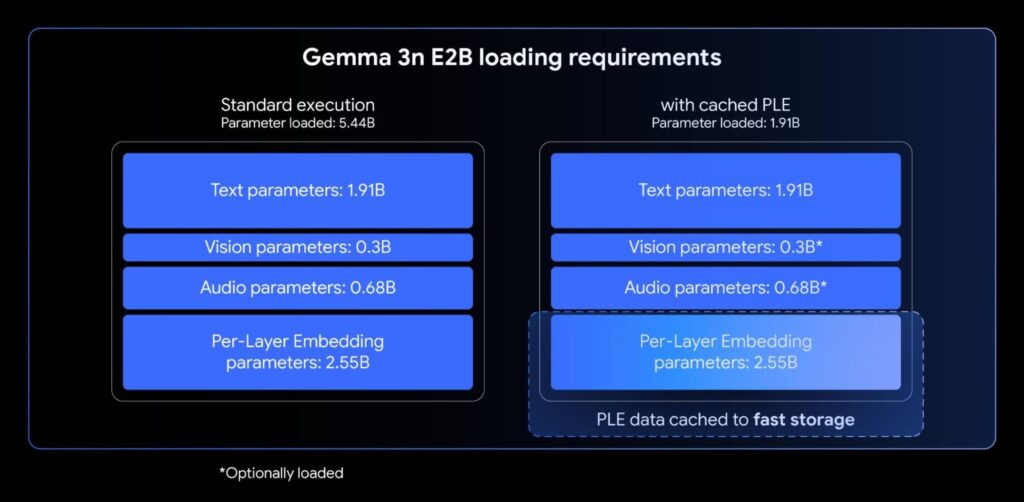

2. Per-Layer Embeddings: memória sob controle

Nos modelos tradicionais, embeddings iniciais consomem muita VRAM. No Gemma 3n, cada camada possui seu próprio bloco de embeddings que pode residir na CPU. Assim, apenas 2B (E2B) ou 4B (E4B) ficam no acelerador, liberando espaço para lotes maiores ou multitarefas sem troca de memória.

3. KV Cache Sharing: resposta mais rápida

Aplicações de áudio e vídeo exigem prompts longos. Com o KV Cache Sharing, as chaves e valores do meio da rede são reutilizados nas camadas superiores, reduzindo o tempo de pré-preenchimento em até 2× quando comparado ao Gemma 3 4B.

4. Encoders MobileNet-V5 e USM: multimodal de verdade

O encoder de visão MobileNet-V5-300M processa até 60 fps em um Pixel, aceita imagens 256-768 px e, mesmo quantizado, entrega 13× mais velocidade que o SoViT usado no Gemma 3. Para áudio, o modelo adota o USM, gerando um token a cada 160 ms. Isso habilita transcrição e tradução de fala diretamente no aparelho — destaque para pares EN-ES/FR/IT/PT.

Benchmarks e casos de uso

No MMLU, o E4B ultrapassa 71 %, próximo ao GPT-4-nano, enquanto consome menos da metade da memória. Na prática, empresas como Roboflow já testam visão industrial offline, e universidades japonesas adaptam Gemma 3n para compatibilidade com caracteres Kanji.

- Saúde offline: triagem inicial em regiões sem internet.

- Assistentes embarcados: dispositivos IoT que precisam de voz, visão e texto sem enviar dados ao servidor.

- Apps educacionais: tradução simultânea e explicações passo a passo sem custos de nuvem.

Como começar agora

Você pode testar o Gemma 3n em Google AI Studio, baixar pesos no Hugging Face ou usar Ollama para gerar contêineres locais. Para fine-tuning, consulte os guias TRL ou NeMo, e publique em escala com Vertex AI ou GenAI API.

“Nossa meta é tornar IA avançada acessível a qualquer pessoa com um smartphone.”

Omar Sanseviero, Google

Desafie-se: Gemma 3n Impact Challenge

O hackathon global oferece US$ 150 000 para projetos que usem as capacidades offline e multimodais do 3n em prol de impacto social. Basta enviar um vídeo demonstrativo e o código-fonte. Inscreva-se até 31 de agosto.

- Categoria Health & Accessibility

- Categoria Education & Culture

- Categoria Sustainability & Climate

Pontos-chave

- Primeiro modelo <10B a passar 1300 no LMArena.

- Funciona com apenas 2-3 GB de memória.

- Multimodal nativo: texto, imagem, áudio e vídeo.

- Ferramentas prontas: Hugging Face, llama.cpp, MLX, Ollama.

- Hackathon com premiação de US$ 150 mil.

O Gemma 3n é totalmente gratuito?

Resposta direta: Sim, o modelo e seus pesos estão disponíveis sem custo para uso e pesquisa, seguindo a licença da Google.Expansão (100-150c): A licença OpenGemma permite baixar, hospedar e ajustar o modelo localmente ou na nuvem, desde que se respeite o uso responsável e a atribuição de crédito à Google.Validação (50-80c): Consulte a política oficial para detalhes de restrições comerciais.

Qual hardware mínimo roda o Gemma 3n?

Resposta direta: Um dispositivo com 2 GB de VRAM já executa a versão E2B.Expansão: Para E4B, são recomendados 3 GB de VRAM (ou RAM unificada) e suporte a instruções INT4/INT8 para melhor desempenho. Em testes, um Pixel 8 gerou 12 tokens/s em INT8.Validação: Dados de benchmark internos divulgados pela Google em 26/06/25.

Posso treinar o modelo com meus próprios dados?

Resposta direta: Sim, via fine-tuning ou LoRA.Expansão: Ferramentas como Hugging Face TRL, Axolotl e Unsloth suportam parameter-efficient fine-tuning. Basta converter o checkpoint Gemma 3n para o formato desejado e treinar com 5-10% do custo de full-training.Validação: Veja o tutorial oficial em Hugging Face.

Considerações finais

O Gemma 3n inaugura uma nova fase da IA generativa: potente, multimodal e, sobretudo, acessível. Ao combinar engenharia de memória, arquitetura elástica e encoders especializados, a Google entrega um pacote pronto para embarcar IA em qualquer dispositivo. Se você é desenvolvedor, o momento de experimentar — e inovar — é agora.