Meta lança SAM Audio: IA para separação de som

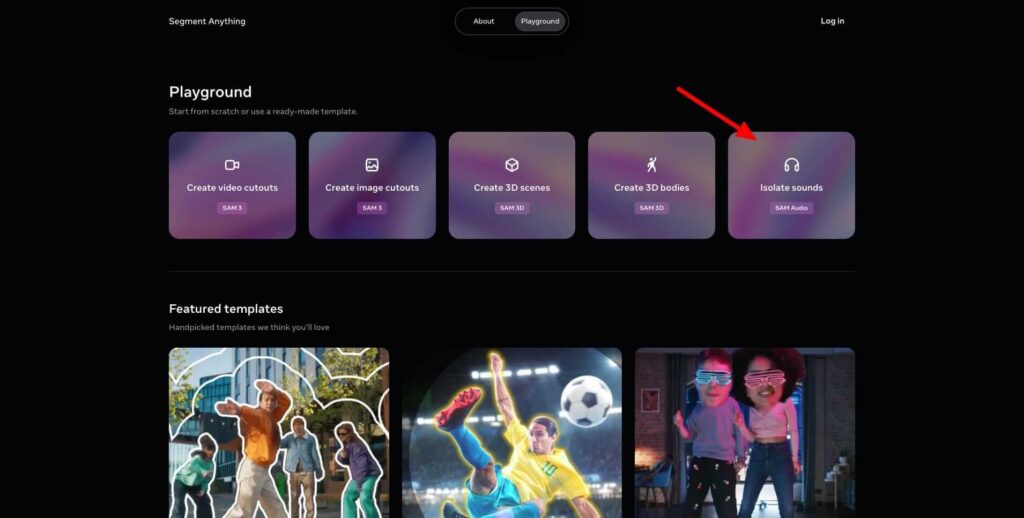

A Meta apresentou oficialmente o SAM Audio, um modelo de inteligência artificial avançado para segmentação sonora, capaz de isolar ou remover elementos específicos dentro de um ambiente de áudio complexo. O novo sistema está disponível para testes no Segment Anything Playground e pode ser baixado por desenvolvedores e criadores do mundo todo.

Tabela de conteúdos

Um salto na edição de áudio com inteligência artificial

O SAM Audio (Segment Anything Model for Audio) é uma extensão do conhecido projeto Segment Anything, da Meta. Enquanto o modelo original focava em elementos visuais, esta nova versão foi treinada para lidar com faixas de som complexas, oferecendo um controle sem precedentes para criadores de conteúdo, músicos, podcasters e profissionais de pós-produção.

De acordo com a Meta, a ferramenta se destaca por integrar três métodos de prompts multimodais, permitindo aos usuários interagir com o áudio por meio de descrição textual, seleção visual ou delimitação de tempo. Essa abordagem representa um avanço significativo em relação a soluções anteriores, que eram limitadas a processos técnicos complexos ou a tarefas únicas.

- Text Prompting: o usuário descreve o som a ser isolado ou removido.

- Visual Prompting: é possível clicar em um objeto ou pessoa em um vídeo para extrair sua componente sonora.

- Span Prompting: o usuário especifica intervalos de tempo para capturar sons específicos.

Impacto para criadores e a indústria do som

Especialistas do setor consideram o SAM Audio um marco para o campo da edição sonora com IA. Testes preliminares destacam sua precisão na separação de sons sobrepostos, tornando-o útil não apenas para designers de som e músicos, mas também para pesquisadores de fala e engenheiros de áudio. Segundo analistas, a ferramenta tem potencial para ampliar a acessibilidade em produções criativas, oferecendo uma interface intuitiva e resultados quase instantâneos.

O SAM Audio foi projetado para ser multiplataforma e open access, seguindo a estratégia da Meta de democratizar tecnologias baseadas em aprendizado de máquina. Assim como outras ferramentas do ecossistema AI @ Meta, ele acompanha modelos de percepção, benchmarks e publicações científicas abertas para fomentar pesquisa colaborativa.

“Estamos lançando o SAM Audio para a comunidade, acompanhado de um modelo de codificador perceptual, referências de desempenho e nossos estudos, para capacitar criadores e desenvolvedores ao redor do mundo.”

@AIatMeta via Twitter

Na publicação oficial, o laboratório AI da Meta destacou que o modelo é o primeiro do gênero capaz de processar diferentes tipos de instruções simultaneamente, o que permite separar instrumentos musicais, remover vozes de fundo ou até capturar sons naturais específicos com um simples comando textual.

Como funciona a tecnologia multimodal do SAM Audio

O diferencial técnico do SAM Audio está na sua arquitetura multimodal. O modelo entende sons de forma contextual e identifica padrões em tempo real, combinando informações textuais, temporais e visuais. Isso o torna útil para aplicações diversas — de análise científica de ruído ambiental até efeitos sonoros cinematográficos.

Em termos práticos, o sistema usa uma camada de percepção neural capaz de mapear sons e associá-los a objetos visuais, como por exemplo uma pessoa falando em meio a instrumentos ou o som de passos em um vídeo. Essa combinação cria um fluxo de trabalho rápido e intuitivo, eliminando a necessidade de softwares de edição complexos.

Disponibilidade e acesso

O SAM Audio já está disponível para experimentação gratuita no Segment Anything Playground e pode ser baixado para implementação local. Desenvolvedores podem também acessar o repositório de código e documentação técnica para adaptar o sistema a aplicações personalizadas.

O lançamento reforça a intenção da Meta de expandir seu ecossistema de ferramentas criativas baseadas em IA, estimulando o uso aberto e colaborativo da tecnologia. Com o aumento da competição no campo da inteligência artificial — envolvendo empresas como OpenAI, Anthropic e Google DeepMind —, esse movimento posiciona a Meta como uma das líderes em pesquisa multimodal aplicada.

O que é o SAM Audio da Meta?

O SAM Audio é um modelo de inteligência artificial desenvolvido pela Meta para realizar separação de som em ambientes complexos. Ele permite isolar, remover ou analisar sons de forma multimodal, usando comandos de texto, imagem e intervalo de tempo.

Como funciona o sistema de prompts do SAM Audio?

O SAM Audio utiliza três métodos de interação — text prompting para comandos escritos, visual prompting para seleção em vídeos e span prompting para escolha temporal. Essa combinação garante controle avançado sobre cada elemento sonoro.

Quem pode usar o SAM Audio?

A ferramenta foi projetada tanto para usuários técnicos quanto iniciantes, incluindo criadores de conteúdo, músicos, editores e pesquisadores de áudio. Está disponível no Segment Anything Playground.

Qual o impacto do SAM Audio na criação de conteúdo?

Com o SAM Audio, a Meta amplia a acessibilidade e a precisão na edição sonora. Sua capacidade de separar faixas complexas e entender o contexto multimodal promete transformar processos de edição e experimentar novos formatos criativos.

Considerações finais

Com o SAM Audio, a Meta reafirma seu compromisso em tornar as tecnologias de IA acessíveis e poderosas. A introdução de um modelo capaz de compreender sons, texto e vídeo simultaneamente abre caminho para uma nova era de edição sonora automatizada. Seja na música, no cinema ou na pesquisa científica, a inteligência artificial da Meta agora tem seu próprio ouvido treinado digitalmente — e o mundo criativo escuta com atenção.