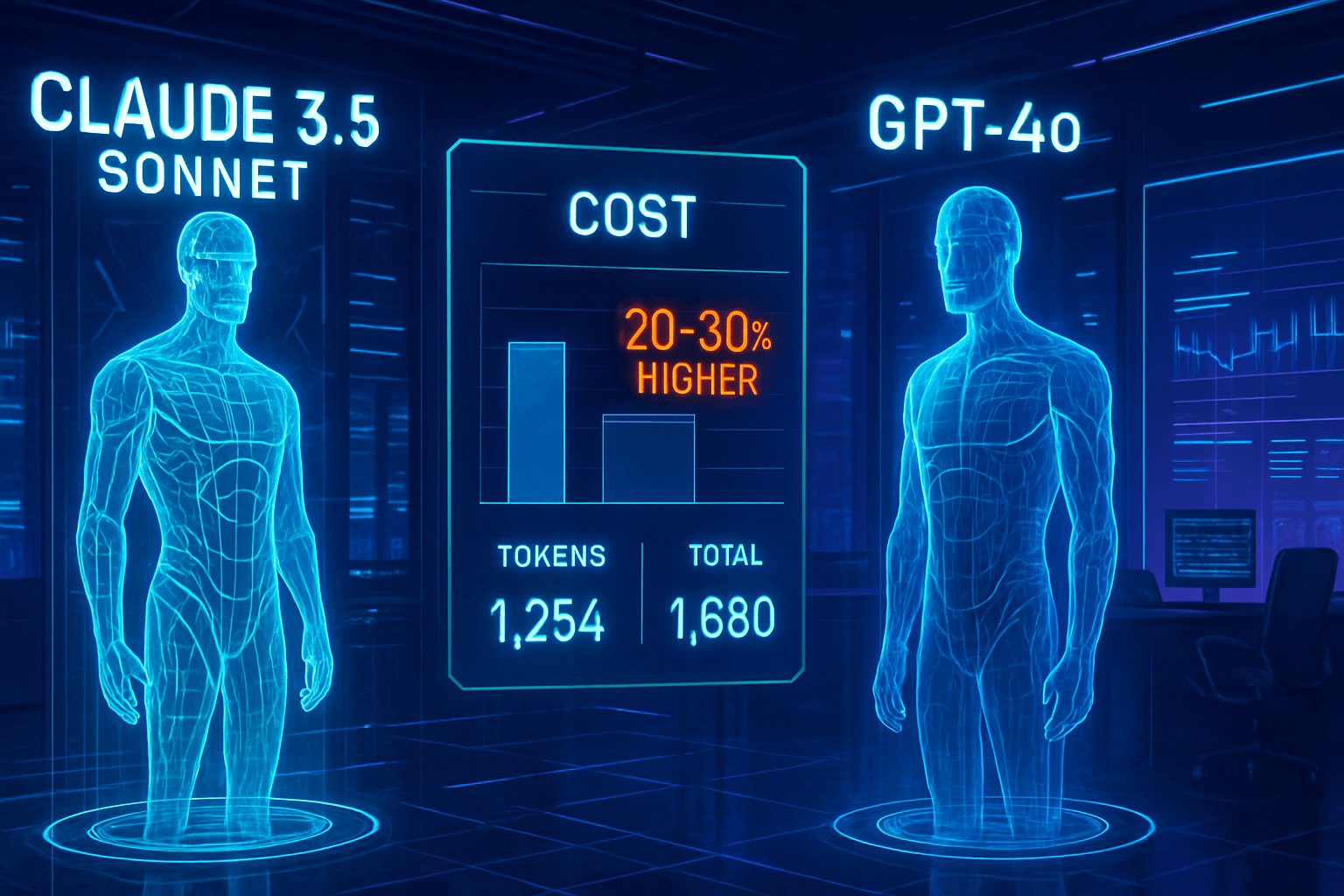

Custo Real Claude vs GPT em 2025: Por Que Claude Pode Ser 20-30% Mais Caro

O custo real de Claude vs GPT revela que modelos Anthropic podem ser 20-30% mais caros que GPT em cenários empresariais, apesar da precificação competitiva por token. Análises de Maio 2025 indicam que a “ineficiência do tokenizer” da Anthropic infla o número de tokens para o mesmo input, impactando o custo total. Este artigo detalha essa diferença oculta, compara custos e tokenização por domínio e explora as implicações práticas para empresas que implementam IA em 2025. Tempo estimado de leitura: 7 minutos.

Tabela de conteúdos

O que é a “Ineficiência do Tokenizer” e Como Afeta o Custo Claude vs GPT?

A “ineficiência do tokenizer” refere-se à tendência do sistema de tokenização da Anthropic (usado nos modelos Claude) de dividir o mesmo texto em um número maior de tokens comparado ao tokenizer da OpenAI (usado nos modelos GPT). Essencialmente, para um prompt idêntico, Claude ‘conta’ mais peças (tokens), inflando o custo, mesmo que o preço *por token* de input seja menor. Pesquisas de 2025 mostram que essa verbosidade não é uniforme, variando conforme o tipo de conteúdo processado.

- Mais Tokens, Mesmo Texto: Claude requer mais tokens para representar a mesma informação que GPT.

- Impacto Direto no Custo: Como a cobrança é por token, mais tokens resultam em custo total maior.

- Variação por Domínio: A ineficiência é mais pronunciada em código e conteúdo técnico.

Qual a Diferença Real de Custo por Token: Claude 3.5 Sonnet vs GPT-4o (Junho 2024)?

À primeira vista, a estrutura de preços da API para Claude 3.5 Sonnet e GPT-4o em meados de 2024 parece competitiva, com Claude oferecendo um custo de input significativamente menor. No entanto, essa tabela não reflete o custo total impactado pela contagem de tokens.

| Modelo | Custo Input (por 1M tokens) | Custo Output (por 1M tokens) |

|---|---|---|

| Claude 3.5 Sonnet | $3 | $15 |

| GPT-4o | $5 | $15 |

Como a Tokenização Varia por Tipo de Conteúdo (Inglês, Código, Matemática)?

A análise comparativa de tokenização revela uma variação significativa dependendo do domínio do conteúdo. A ineficiência do tokenizer da Anthropic é mais acentuada em textos com estruturas e símbolos específicos, como código e matemática.

Qual o Impacto da Tokenização no Tamanho Efetivo da Janela de Contexto?

Além do custo direto, a maior contagem de tokens do Claude impacta a utilização da janela de contexto. Embora Claude 3.5 Sonnet anuncie uma janela maior (200K tokens) que a do GPT-4o (128K tokens), a verbosidade do tokenizer pode significar que o espaço útil efetivo para o conteúdo seja proporcionalmente menor. Em outras palavras, a janela de 200K do Claude pode ‘encher’ mais rápido com o mesmo volume de informação textual, reduzindo a vantagem teórica em certos casos de uso intensivo de contexto.

Quais São os Tokenizers Usados por Claude e GPT?

Os modelos GPT da OpenAI utilizam variações do Byte Pair Encoding (BPE), especificamente o tokenizer open-source `o200k_base` para modelos como GPT-4o. Este método é conhecido por agrupar pares de caracteres frequentes.

Já a Anthropic utiliza um tokenizer próprio, cujos detalhes são menos públicos. Relatos (como da Latenode) sugerem que ele pode ter um vocabulário menor (cerca de 65k variações vs. 100k+ da OpenAI), o que pode contribuir para a fragmentação maior do texto em tokens. A falta de acesso fácil ao tokenizer da Anthropic dificulta a estimativa precisa de custos sem chamadas diretas à API, um desafio para orçamentação empresarial.

A comunidade de pesquisa em IA observou diferenças semelhantes de tokenização, como documentado [nesta issue do GitHub](https://github.com/gkamradt/LLMTest_NeedleInAHaystack/issues/25#issue-2172585625) (link externo, em inglês).

Comunidade AI/GitHub

Validação e Evidências Empíricas (2024-2025)

A análise apresentada por VentureBeat em Maio de 2025, baseada em testes práticos, corrobora as observações da comunidade. Ferramentas como o [Colab notebook e o Tokenizer Playground (link externo) permitem explorar essas diferenças. Por exemplo, processar 10.000 linhas de código Python poderia realisticamente resultar em ~3 milhões de tokens via Claude vs. ~2.3 milhões via GPT-4o, uma diferença de custo substancial em projetos de larga escala. A Anthropic não comentou os achados até a data de publicação original.

Implicações Estratégicas e Como Mitigar Custos Ocultos

Empresas que utilizam LLMs em escala devem ir além da simples comparação de preços por token. A ineficiência do tokenizer representa um custo operacional real que precisa ser modelado. Estratégias de mitigação podem incluir:

- Análise de Custo por Caso de Uso: Avaliar o custo real com base no tipo predominante de conteúdo processado (texto, código, dados estruturados).

- Benchmarking Interno: Realizar testes A/B com amostras de dados reais da empresa em ambos os modelos para validar o custo efetivo.

- Pré-processamento de Texto: Experimentar técnicas para simplificar ou reformatar inputs antes de enviá-los à API, especialmente para código e dados técnicos.

- Seleção Dinâmica de Modelo: Considerar o uso de modelos diferentes (até mesmo versões mais antigas ou menores) para tarefas onde a performance de ponta do Claude 3.5 ou GPT-4o não seja estritamente necessária. [Link interno para guia de seleção de LLMs]

- Monitoramento Contínuo: Acompanhar de perto os custos e a contagem de tokens, pois os tokenizers e modelos podem ser atualizados.

- Custo Enganoso: Preços de input mais baixos de Claude 3.5 Sonnet podem ser anulados pela maior contagem de tokens gerada.

- Ineficiência Oculta: O tokenizer da Anthropic é inerentemente mais verboso, especialmente para código (~30% mais tokens) e matemática (~21%).

- Domínio é Crucial: Avalie o tipo de texto predominante; para linguagem natural, a diferença pode ser menor (~16%).

- Janela de Contexto Efetiva: A janela maior de Claude (200K) pode ter menos espaço útil real devido à verbosidade comparada à de GPT-4o (128K).

- Planejamento de Custos: A dificuldade em estimar tokens do Claude exige benchmarking e monitoramento rigoroso.

A dificuldade em estimar proativamente os tokens do Claude adiciona uma camada de incerteza ao planejamento financeiro de projetos de IA. Ferramentas de terceiros ou bibliotecas que tentam replicar o tokenizer podem oferecer aproximações, mas a precisão não é garantida. [Link interno para artigo sobre ferramentas de estimativa de custo de IA]

Principais pontos

Custo Claude vs GPT e Tokenização

Claude 3.5 Sonnet é realmente mais caro que GPT-4o no uso prático?

Por que o tokenizer do Claude gera mais tokens?

Essa diferença de custo na tokenização Claude vs GPT se aplica a todos os tipos de texto?

Como posso estimar meus custos reais com Claude 3.5 Sonnet vs GPT-4o?

A janela de contexto maior do Claude (200K) compensa o custo extra de tokenização?

Qual modelo devo escolher para minha empresa: Claude 3.5 Sonnet ou GPT-4o?

Conclusão: Olhe Além do Preço por Token

A comparação de custos entre Claude 3.5 Sonnet e GPT-4o em 2025 destaca a importância de analisar além das tabelas de preço. A “ineficiência do tokenizer” da Anthropic introduz um custo oculto significativo, especialmente para aplicações empresariais que lidam com código ou dados técnicos. Empresas devem realizar benchmarking com dados reais para tomar decisões informadas, considerando tanto o custo efetivo quanto a performance e as necessidades de contexto específicas de cada caso de uso. Monitorar essa dinâmica é crucial em um cenário de IA em rápida evolução.