LLM Customização: Fine-tuning ou ICL? Nova Pesquisa Orienta

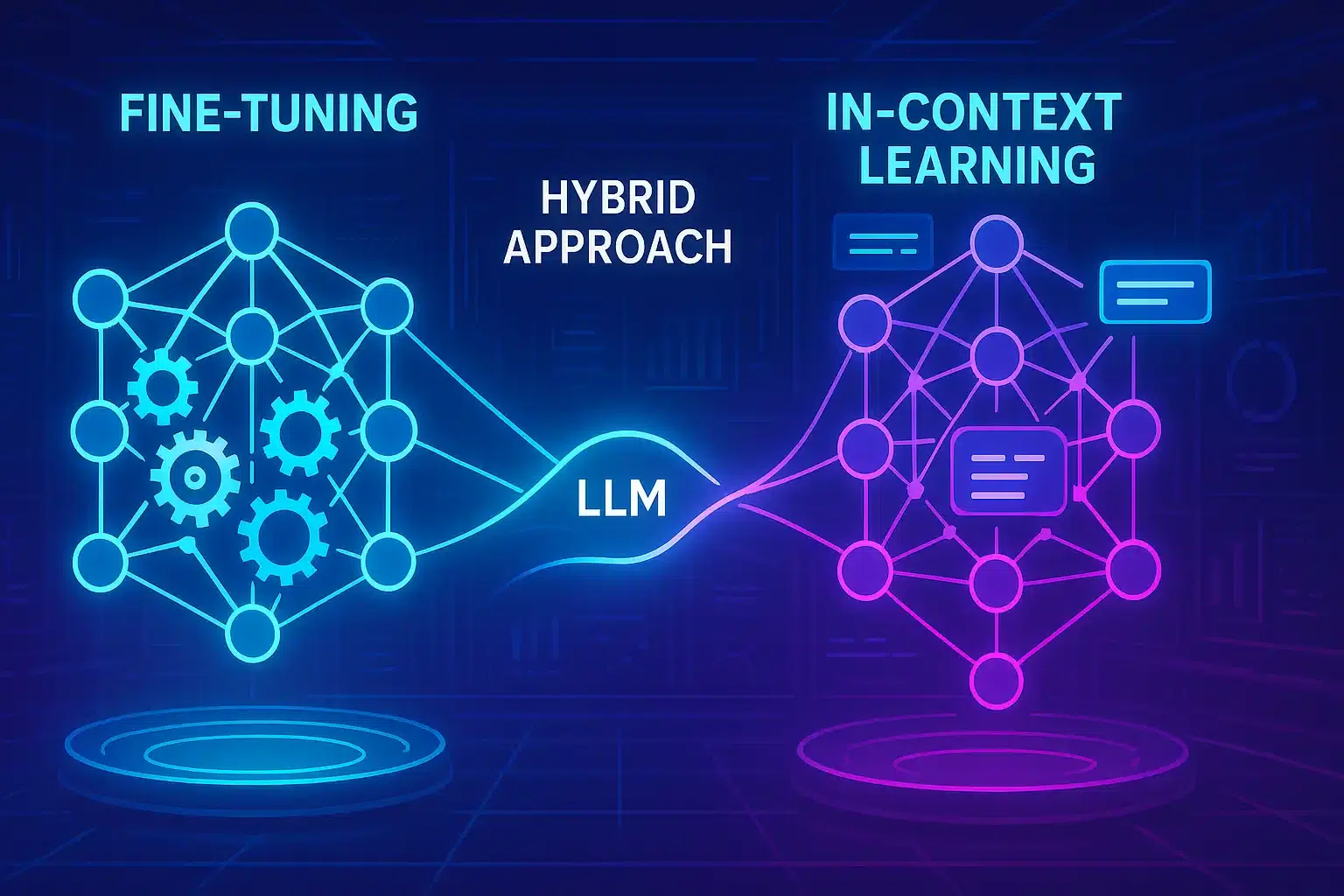

Uma nova pesquisa conduzida por cientistas do Google DeepMind e da Universidade de Stanford, publicada em 9 de maio de 2025, investiga a fundo duas abordagens populares para customização de Modelos de Linguagem Grandes (LLMs): fine-tuning e aprendizado in-context (ICL). O estudo revela que o ICL demonstra maior capacidade de generalização, embora com maior custo computacional na inferência, e propõe uma inovadora abordagem híbrida, o fine-tuning aumentado, para otimizar o desempenho em tarefas do mundo real, crucial para empresas que buscam adaptar LLMs aos seus dados proprietários.

Tabela de conteúdos

Entendendo Fine-Tuning e In-Context Learning (ICL)

A personalização de LLMs é vital para sua aplicação eficaz em cenários específicos. O fine-tuning envolve o retreinamento de um LLM pré-treinado com um conjunto de dados menor e especializado. Esse processo ajusta os parâmetros internos do modelo, ensinando-lhe novos conhecimentos ou habilidades. Por outro lado, o aprendizado in-context (ICL) não altera os parâmetros subjacentes do modelo. Em vez disso, guia o LLM fornecendo exemplos da tarefa desejada diretamente no prompt de entrada, permitindo que o modelo deduza como lidar com uma nova consulta semelhante.

Metodologia da Pesquisa: Testando a Generalização

Para comparar rigorosamente a capacidade de generalização, os pesquisadores, conforme detalhado no estudo disponível em arXiv:2505.00661, construíram “conjuntos de dados sintéticos controlados de conhecimento factual” com estruturas complexas e autoconsistentes, como árvores genealógicas imaginárias. Para garantir que testavam a capacidade do modelo de aprender novas informações, substantivos, adjetivos e verbos foram substituídos por termos sem sentido, evitando sobreposição com dados de pré-treinamento. O modelo Gemini 1.5 Flash foi utilizado para os testes de fine-tuning.

- Testes de Reversão Simples: Se o modelo aprende que “femp são mais perigosos que glon”, ele consegue inferir que “glon são menos perigosos que femp”?

- Silogismos Simples: Se informado “Todos os glon são yomp” e “Todos os troff são glon”, o modelo deduz que “Todos os troff são yomp”?

Andrew Lampinen, Cientista de Pesquisa no Google DeepMind e autor principal do artigo, afirmou: “Nossos resultados focam primariamente em como os modelos generalizam para deduções e reversões a partir do fine-tuning em novas estruturas de conhecimento, com implicações claras para situações onde o fine-tuning é usado para adaptar um modelo a informações específicas e proprietárias da empresa.”

Descobertas Chave: ICL Leva Vantagem na Generalização

Os resultados mostraram consistentemente que, em cenários com dados equivalentes, o ICL levou a uma melhor generalização do que o fine-tuning padrão. Modelos usando ICL foram geralmente mais eficazes em tarefas como reverter relações ou fazer deduções lógicas a partir do contexto fornecido. Modelos pré-treinados, sem fine-tuning ou ICL, tiveram desempenho ruim, indicando a novidade dos dados de teste.

“Uma das principais compensações a considerar é que, embora o ICL não exija fine-tuning (o que economiza custos de treinamento), ele é geralmente mais caro computacionalmente a cada uso, pois requer o fornecimento de contexto adicional ao modelo. Por outro lado, o ICL tende a generalizar melhor para os conjuntos de dados e modelos que avaliamos.”

Andrew Lampinen, Google DeepMind

Fine-Tuning Aumentado: Uma Abordagem Híbrida Promissora

Com base na observação de que o ICL se destaca na generalização flexível, os pesquisadores propuseram um novo método para aprimorar o fine-tuning: adicionar inferências in-context aos dados de fine-tuning. A ideia central é usar as próprias capacidades de ICL do LLM para gerar exemplos mais diversos e ricamente inferidos, e então adicionar esses exemplos aumentados ao conjunto de dados usado para o fine-tuning.

Duas estratégias de aumento de dados foram exploradas:

- Estratégia Local: Foca em informações individuais. O LLM é instruído a reformular frases únicas dos dados de treinamento ou extrair inferências diretas delas.

- Estratégia Global: O LLM recebe o conjunto de dados de treinamento completo como contexto e é instruído a gerar inferências ligando um documento ou fato específico com o restante das informações fornecidas.

Os modelos ajustados com esses conjuntos de dados aumentados apresentaram ganhos significativos. Esse fine-tuning aumentado melhorou notavelmente a generalização, superando não apenas o fine-tuning padrão, mas também o ICL simples. A pesquisa sugere que essa abordagem é mais eficaz para permitir que o modelo responda a perguntas relacionadas a informações específicas, como identificar ferramentas internas para análise de dados com base em documentos da empresa.

Implicações para Empresas e Desenvolvedores de IA

Esta abordagem híbrida oferece um caminho promissor para empresas. Ao investir na criação desses conjuntos de dados aumentados por ICL, os desenvolvedores podem construir modelos ajustados que exibem capacidades de generalização mais fortes. Isso pode levar a aplicações de LLM mais robustas e confiáveis que performam melhor em entradas diversas do mundo real, sem incorrer nos custos contínuos de tempo de inferência associados a grandes prompts in-context.

Lampinen observa que, embora o fine-tuning aumentado possa tornar o processo inicial mais caro, o custo pode ser amortizado ao longo de muitos usos do modelo, sendo computacionalmente mais barato do que aplicar ICL a cada vez. Ele sugere que desenvolvedores explorem o fine-tuning aumentado caso observem desempenho inadequado com o fine-tuning isolado.

Considerações finais

A pesquisa do Google DeepMind e da Universidade de Stanford fornece insights valiosos para a customização de LLMs. Embora o ICL mostre superioridade na generalização, o custo computacional é uma barreira. A proposta do fine-tuning aumentado surge como uma solução equilibrada, combinando a flexibilidade do ICL com a eficiência do fine-tuning, pavimentando o caminho para LLMs mais adaptáveis e eficazes em aplicações empresariais. Espera-se que este trabalho contribua para a ciência da compreensão da aprendizagem e generalização em modelos de fundação e para as práticas de adaptação a tarefas específicas.

FAQ Estratégica sobre Customização de LLM

Qual a principal diferença entre fine-tuning e in-context learning (ICL) para LLMs?

Fine-tuning altera os pesos internos de um LLM treinando-o com dados específicos da tarefa (40-60c). Isso especializa o modelo. ICL, por outro lado, guia o LLM com exemplos no prompt, sem modificar seus parâmetros, usando o conhecimento pré-existente para inferir a tarefa (100-150c). Fine-tuning é um retrabalho do modelo; ICL é uma instrução no momento do uso (50-80c).

Por que o ICL generaliza melhor que o fine-tuning tradicional, segundo o estudo?

ICL demonstrou melhor capacidade de realizar inferências lógicas e reversões com base nos exemplos fornecidos no prompt (40-60c). O estudo sugere que fornecer contexto amplo permite ao LLM acessar e aplicar seu conhecimento latente de forma mais flexível do que quando seus pesos são rigidamente ajustados pelo fine-tuning para um conjunto de dados limitado (100-150c). Isso resulta em melhor adaptação a variações da tarefa não vistas explicitamente no treinamento (50-80c).

O que é fine-tuning aumentado e qual sua principal vantagem?

Fine-tuning aumentado é uma técnica híbrida que enriquece os dados de fine-tuning com inferências geradas pelo próprio LLM via ICL (40-60c). Sua principal vantagem é combinar a eficiência de inferência do fine-tuning com a superior capacidade de generalização do ICL, resultando em modelos mais robustos e adaptáveis (100-150c). Ele supera tanto o fine-tuning padrão quanto o ICL isolado em termos de generalização, segundo a pesquisa (50-80c).