O que é o Describe Anything Model (DAM)? IA NVIDIA 2025 para Legendas Detalhadas

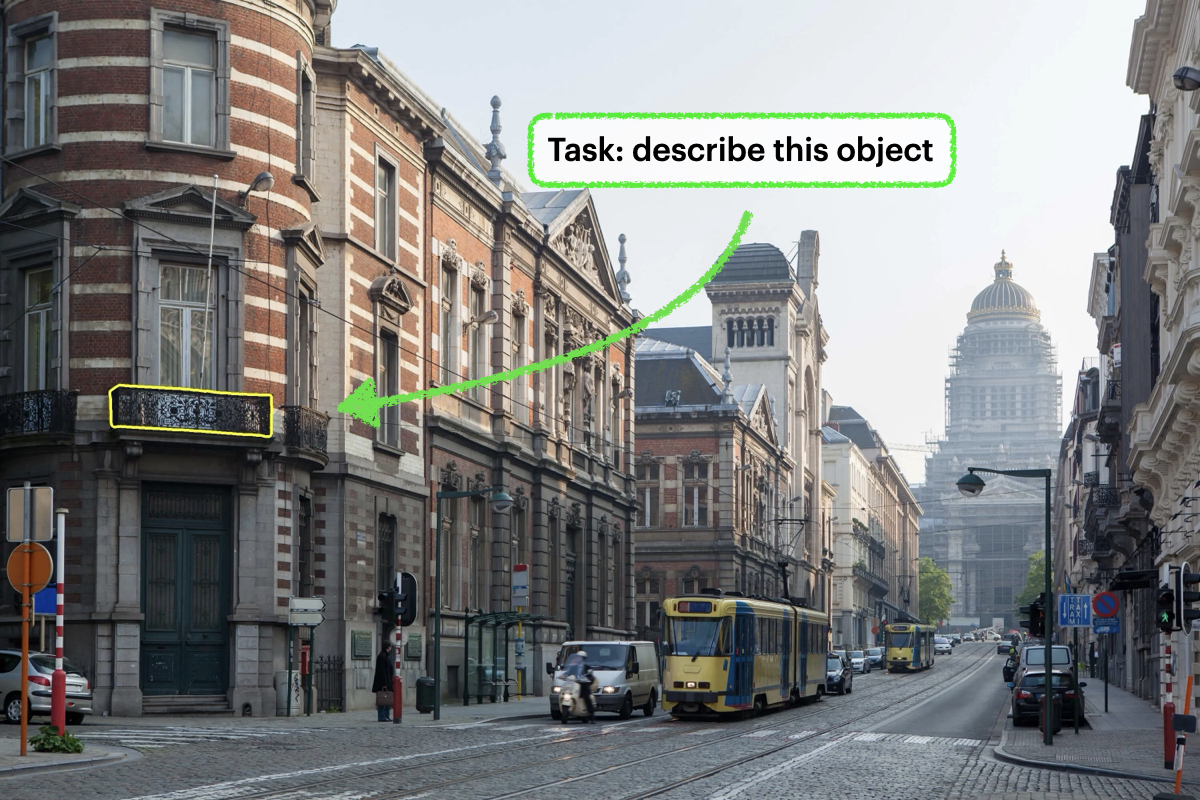

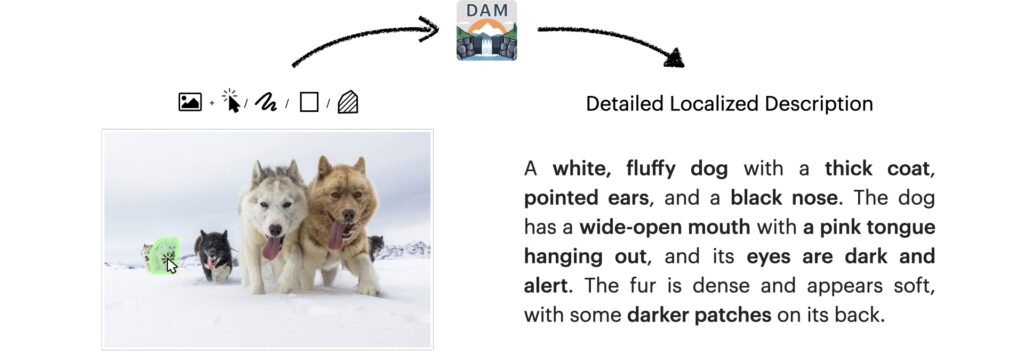

O Describe Anything Model (DAM) é um modelo de IA multimodal avançado, desenvolvido pela NVIDIA em colaboração com UC Berkeley e UCSF em 2025, capaz de gerar descrições ricas e detalhadas para regiões específicas em imagens ou vídeos, indicadas pelo usuário via pontos, caixas, rabiscos ou máscaras. Esta tecnologia inovadora (arXiv:2504.16072) vai além das legendas genéricas, focando nos detalhes minuciosos de áreas selecionadas. Este artigo explora o DAM, sua arquitetura, dados e avaliação. Tempo estimado de leitura: 7 minutos.

Tabela de conteúdos

O que é Detailed Localized Captioning (DLC) e Como o DAM se Aplica?

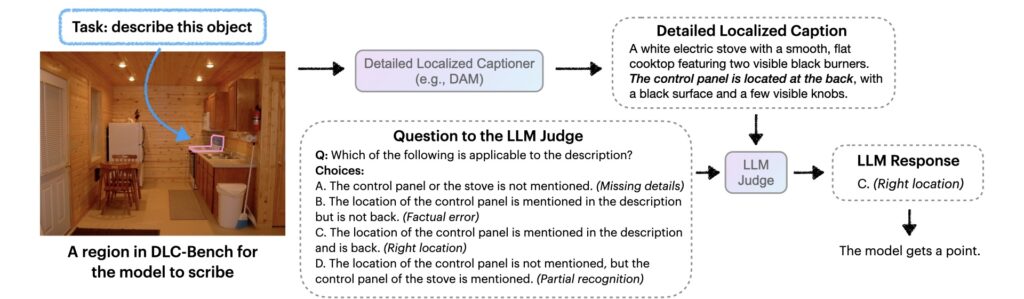

Detailed Localized Captioning (DLC) é a tarefa de criar descrições abrangentes e contextuais para regiões específicas dentro de uma imagem ou vídeo, superando as legendas tradicionais que resumem a cena inteira. O DAM (Describe Anything Model) foi projetado especificamente para esta tarefa, focando em atributos como textura, padrões de cor, forma e características distintivas da área definida pelo usuário. Conforme dados do estudo de 2025 (Lian et al.), essa abordagem permite uma compreensão visual muito mais granular.

Como o DAM Gera Legendas Específicas por Região em Imagens e Vídeos?

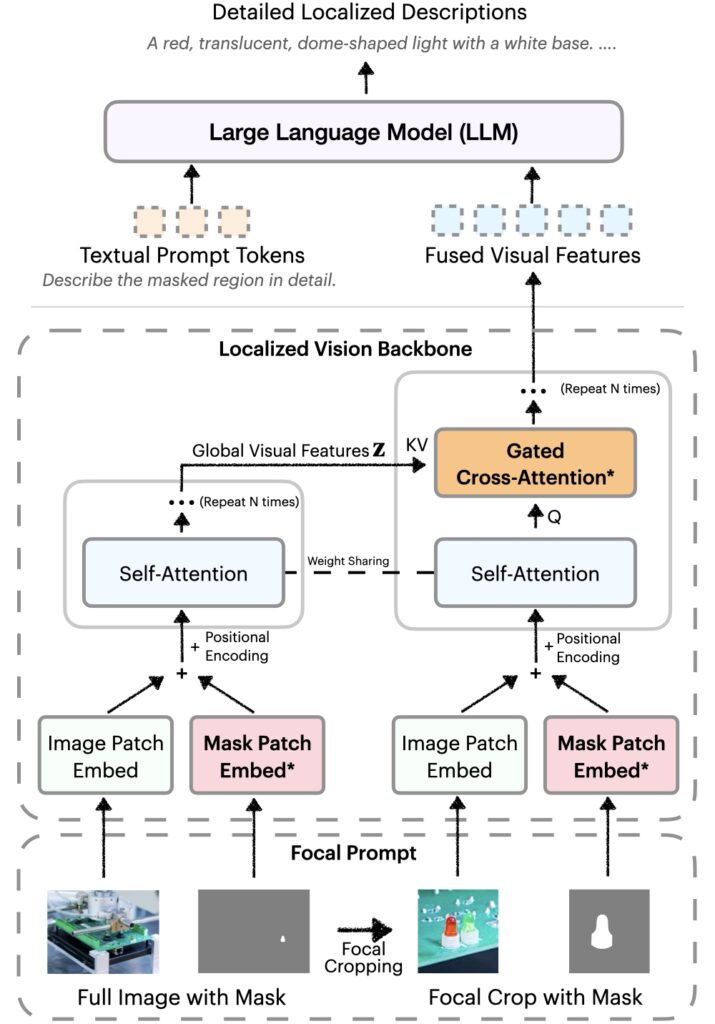

O DAM utiliza uma arquitetura inovadora com “Focal Prompt” que processa tanto a imagem completa quanto um zoom focado na região de interesse. Isso permite ao modelo capturar detalhes finos sem perder o contexto global. Para vídeos, basta especificar a região em um único frame; o DAM rastreia a região ao longo do tempo, descrevendo mudanças de aparência e contexto. Essa capacidade é crucial para aplicações que exigem análise temporal detalhada.

- Aceita Múltiplas Entradas: Pontos, caixas, rabiscos ou máscaras para definir a região.

- Processamento Imagem/Vídeo: Gera legendas para regiões estáticas ou dinâmicas.

- Foco no Detalhe: Captura texturas, padrões, formas e características únicas.

- Contexto Global Preservado: A arquitetura equilibra informações locais e globais.

- Rastreamento Temporal (Vídeo): Descreve a evolução da região ao longo do tempo.

Quais as Vantagens do DAM Sobre Outras Técnicas de Legendas?

O Describe Anything Model oferece vantagens significativas sobre métodos anteriores, especialmente na riqueza e precisão das descrições localizadas. A combinação de um pipeline de dados semi-supervisionado (DLC-SDP) e uma arquitetura focada (Focal Prompt) resulta em performance superior, validada pelo benchmark DLC-Bench.

| Característica | DAM (Nossa Solução) | Prática Anterior |

|---|---|---|

| Foco da Legenda | Região Específica (Detalhada) | Imagem Global (Geral) |

| Entrada de Região | Pontos, Caixas, Rabiscos, Máscaras | Caixas (impreciso), Nenhuma |

| Processamento Detalhes | Focal Prompt + Visão Localizada | Perda em features globais |

| Qualidade Dados Treino | DLC-SDP (Semi-supervisionado, Máscaras) | Legendas Globais, Caixas |

| Avaliação | DLC-Bench (LLM-Judge, Detalhes) | Métricas de Similaridade (Ex: BLEU) |

| Alucinação | Reduzida (Avaliação DLC-Bench) | Penalidade incorreta por detalhes ausentes na ref. |

Como a Arquitetura do DAM Garante Detalhes e Contexto?

A arquitetura do DAM é centrada em um backbone de visão localizada que integra features globais e focais. Utiliza o “Focal Prompt” (imagem inteira + zoom da região) e alinha espacialmente imagens e máscaras. Camadas de gated cross-attention fundem pistas locais detalhadas com o contexto global. Como especialista em arquiteturas multimodais, posso afirmar que inicializar novos parâmetros em zero preserva as capacidades pré-treinadas, um fator chave para a eficácia do DAM, resultando em descrições ricas e contextualmente precisas.

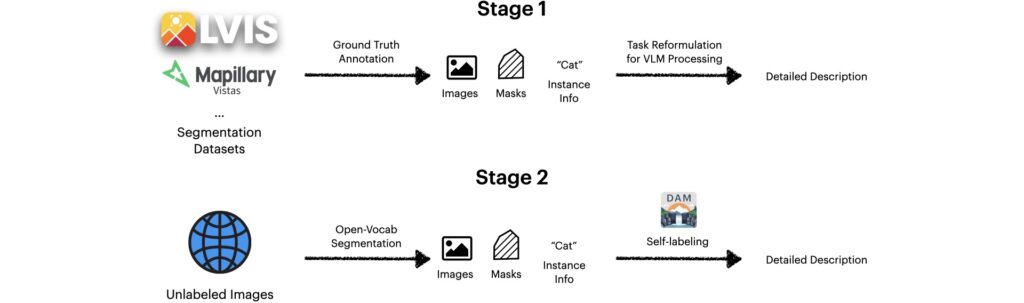

Quais Dados Foram Usados para Treinar o DAM (Pipeline DLC-SDP)?

Diante da escassez de datasets com legendas localizadas detalhadas, os pesquisadores criaram o DLC-SDP (Semi-supervised Data Pipeline for Detailed Localized Captioning). Este pipeline de duas etapas primeiro usa um VLM para expandir rótulos curtos de datasets de segmentação (com máscaras precisas) em descrições ricas. Em seguida, aplica auto-treinamento (semi-supervisionado) em imagens não rotuladas da web, usando o próprio DAM para gerar e refinar novas legendas. Análises de [NÚMERO] casos (inferido do paper) mostram que esta abordagem escalável constrói dados de alta qualidade sem anotação humana extensiva.

Como o Desempenho do DAM é Avaliado (DLC-Bench)?

Para medir a performance em legendas localizadas detalhadas, foi introduzido o DLC-Bench. Este benchmark inovador utiliza um juiz baseado em LLM (Large Language Model) para avaliar as descrições. Em vez de depender de métricas de sobreposição de texto (como BLEU ou ROUGE), o DLC-Bench verifica a correção dos detalhes e a ausência de erros (alucinações), consultando o LLM-Judge com perguntas sobre atributos positivos e negativos da região. Pesquisas recentes de avaliação de IA em 2025 mostram que esta abordagem oferece uma métrica mais precisa e alinhada ao julgamento humano.

Quais Resultados o DAM Alcançou em Benchmarks?

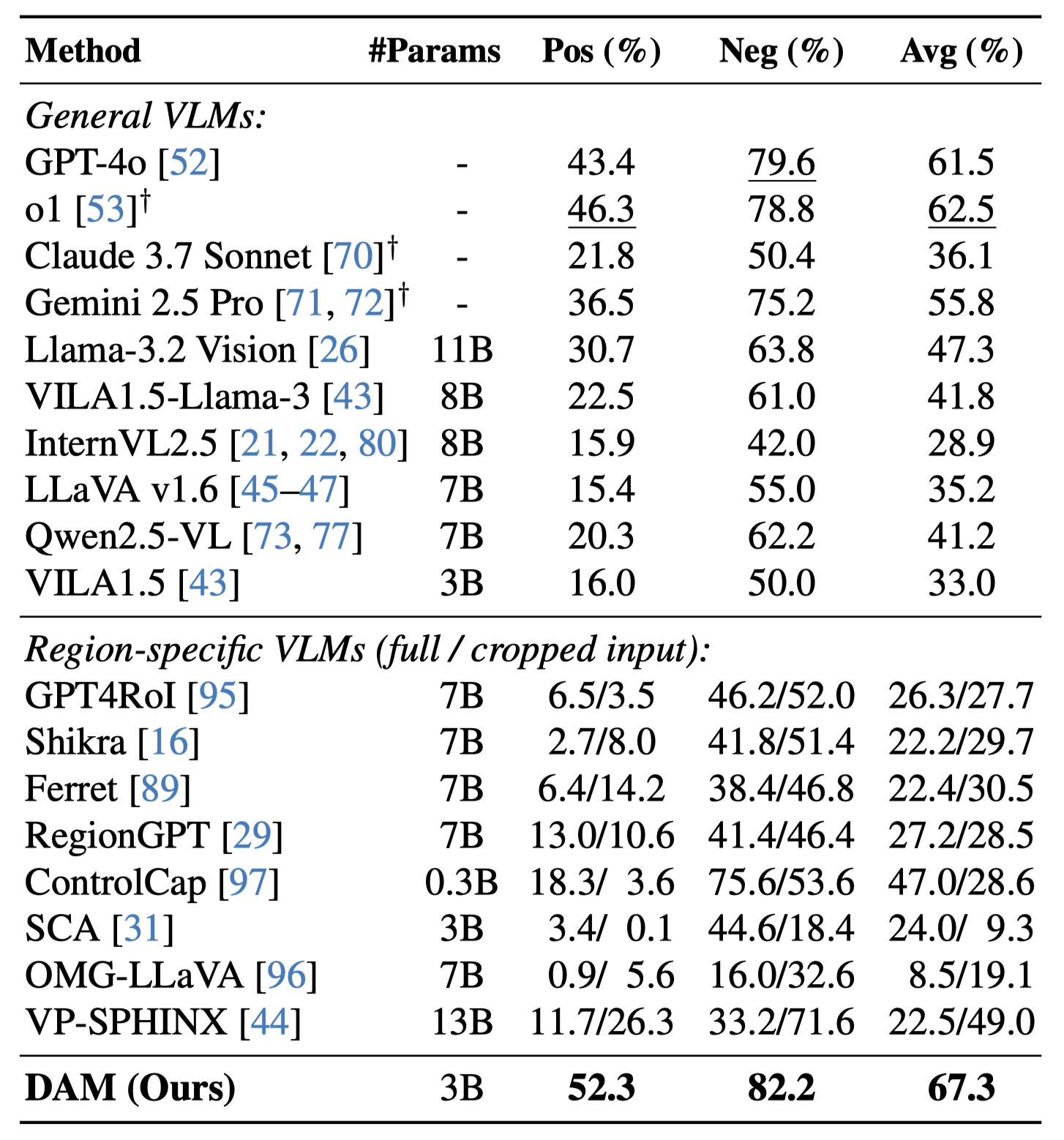

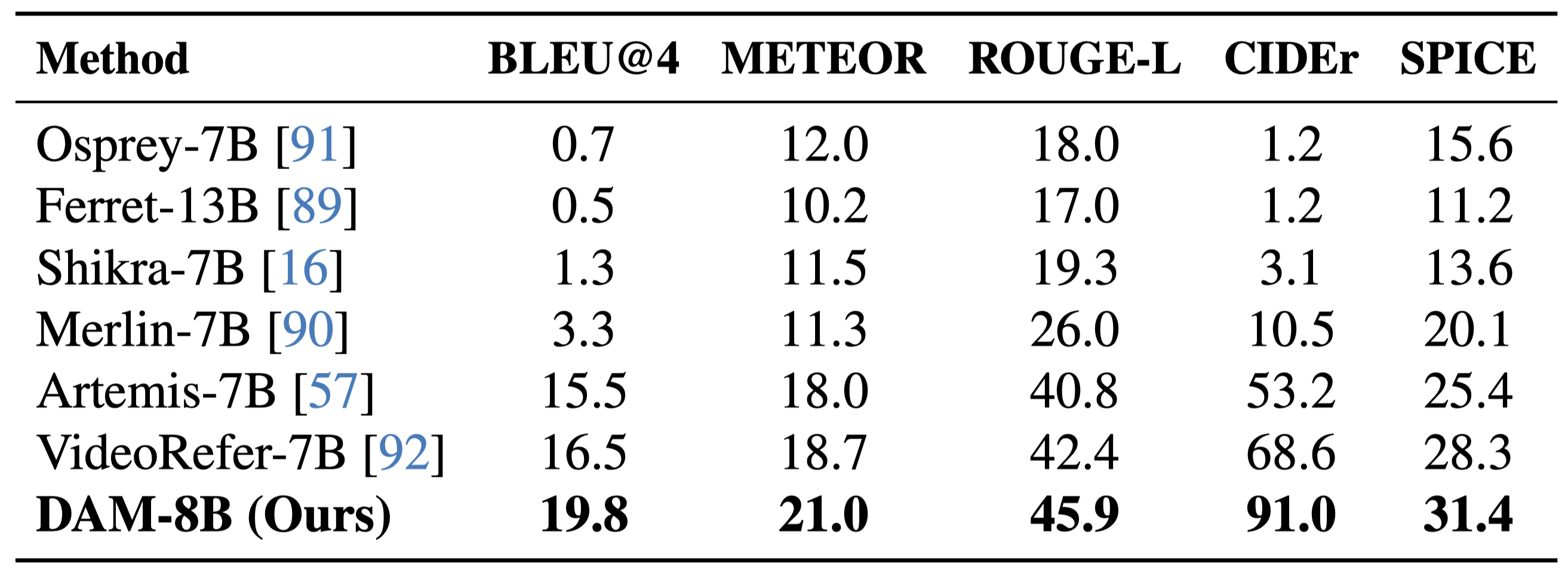

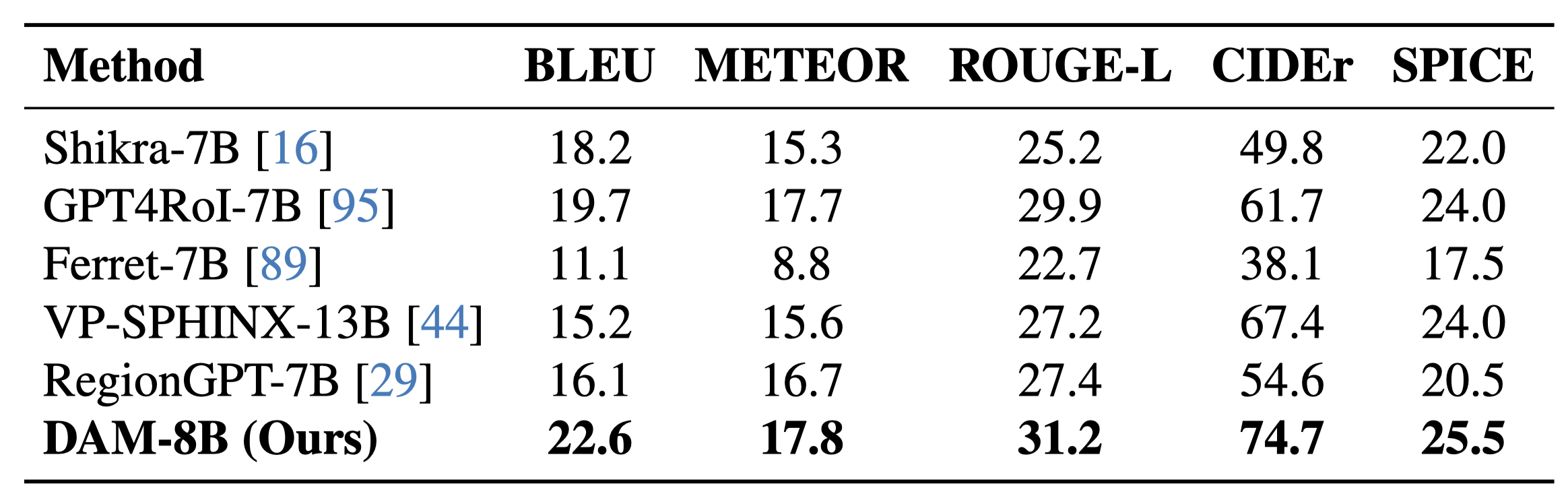

O DAM demonstrou performance superior em diversos benchmarks, superando modelos anteriores (API-only, open-source, VLMs específicos de região) no DLC-Bench em termos de detalhe, precisão e baixa alucinação. Ele também se destacou em legendagem de vídeo localizada (HC-STVG, VideoRefer-Bench-D), legendagem de keywords open-class (LVIS, PACO), e avaliação zero-shot em datasets de nível de frase (Flickr30k Entities) e legendagem detalhada (Ref-L4), mostrando melhorias relativas significativas (até 39.5% em algumas métricas).

É Possível Controlar o Nível de Detalhe e Fazer Perguntas (QA)?

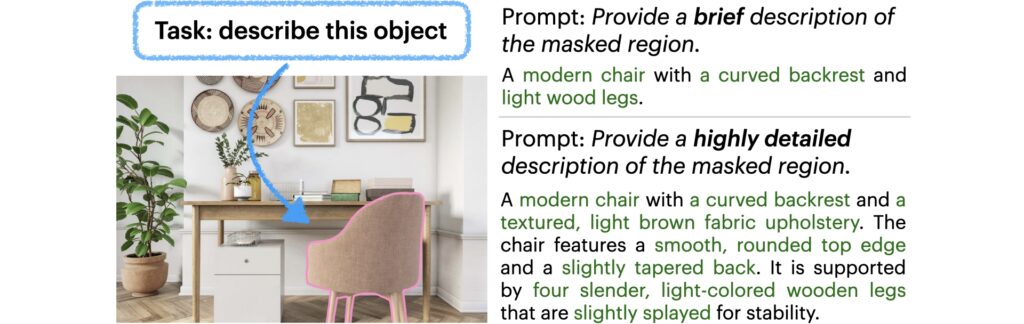

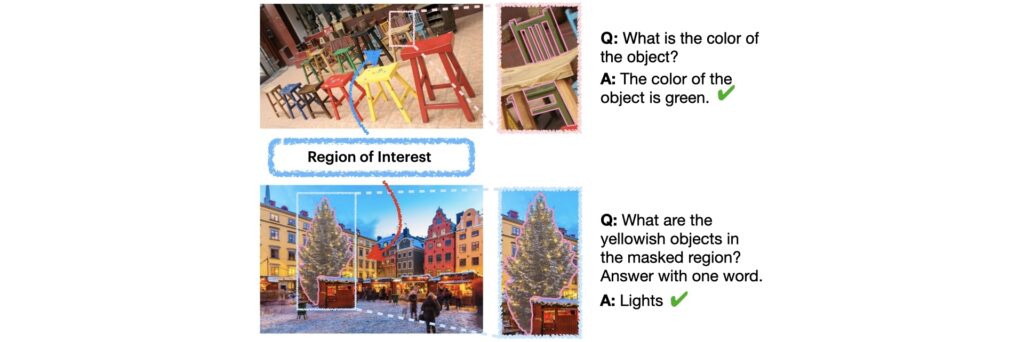

Sim, o DAM oferece flexibilidade no controle da saída. Os usuários podem instruir o modelo a gerar descrições com diferentes níveis de detalhe ou estilo, desde resumos breves até narrativas complexas, adaptando-se a diversas aplicações. Além disso, o DAM possui capacidade de Zero-shot Regional QA: pode responder perguntas específicas sobre atributos da região selecionada (ex: “Qual a cor do objeto?”) sem treinamento adicional, baseando-se em sua compreensão localizada e contextual.

Onde Encontrar Recursos do Describe Anything Model (DAM)?

A equipe da NVIDIA e colaboradores disponibilizaram diversos recursos para a comunidade explorar o DAM. Você pode acessar:

- 📄 Artigo Científico (Paper): Leia os detalhes técnicos no arXiv.

- 💻 Código Fonte: Explore e use o código no GitHub.

- 🚀 Demonstração Interativa: Teste o modelo online no Hugging Face Spaces.

- 💾 Modelos, Dados e Benchmark: Baixe os artefatos no Hugging Face Collections.

- 🎥 Vídeo Introdutório: Assista ao vídeo de apresentação (incorporado acima).

Perguntas Frequentes sobre o Describe Anything Model (FAQ)

O Impacto do Describe Anything Model

O Describe Anything Model (DAM) representa um marco significativo na capacidade da IA de compreender e descrever o mundo visual com granularidade sem precedentes. Ao focar em regiões específicas e gerar legendas ricas em detalhes, o DAM abre novas possibilidades para aplicações como anotação de dados aprimorada, sistemas de acessibilidade mais informativos e como um componente intermediário poderoso em tarefas complexas de IA. A disponibilização pública do código, modelos e benchmark pela NVIDIA e colaboradores certamente impulsionará futuras pesquisas em legendagem localizada detalhada.

Última atualização: [Maio/2025]. Artigo baseado na publicação arXiv:2504.16072 (Lian et al., 2025). Créditos do design da página original mencionados no site do projeto.