Qwen3: O Novo Modelo de IA Híbrido para Raciocínio Profundo e Ação Rápida [2025]

Qwen3 é a mais recente família de modelos de linguagem grandes (LLMs) de código aberto, projetada para pensar mais profundamente e agir mais rapidamente. Lançado em Abril de 2025, seu modelo principal, Qwen3-235B-A22B, demonstra performance competitiva em benchmarks de código, matemática e capacidades gerais contra modelos de ponta.

Esta série introduz modos de pensamento híbridos inovadores e disponibiliza vários modelos, incluindo eficientes MoEs (Mistura de Especialistas), sob a licença Apache 2.0, capacitando desenvolvedores e pesquisadores globalmente. Tempo estimado de leitura: 10 minutos.

Tabela de conteúdos

O que são os Modos de Pensamento Híbridos do Qwen3?

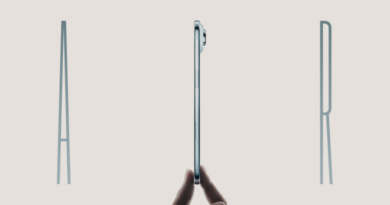

Os Modos de Pensamento Híbridos são uma característica central do Qwen3, oferecendo flexibilidade única no processamento de informações. Esta abordagem permite que o modelo opere em dois modos distintos: Modo Pensamento (Thinking Mode), onde raciocina passo a passo antes de entregar a resposta final, ideal para problemas complexos; e Modo Não-Pensamento (Non-Thinking Mode), fornecendo respostas rápidas e quase instantâneas para questões mais simples.

Essa dualidade, conforme detalhado pela Qwen Team em 2025, permite um controle eficiente do ‘orçamento de pensamento’, otimizando o equilíbrio entre custo computacional e qualidade da inferência, adaptando-se dinamicamente à complexidade da tarefa.

![Qwen3: O Novo Modelo de IA Híbrido para Raciocínio Profundo e Ação Rápida [2025] 8 A performance escalável do Qwen3 em relação ao orçamento de raciocínio demonstra a eficácia dos modos híbridos](https://rendageek.com.br/wp-content/uploads/2025/04/thinking_budget-scaled.png)

Quais modelos Qwen3 estão disponíveis e suas especificações?

A família Qwen3 inclui uma gama diversificada de modelos, desde opções compactas até modelos de Mistura de Especialistas (MoE) de larga escala, todos lançados sob a licença Apache 2.0 em 2025. Os modelos disponíveis incluem seis modelos densos (0.6B, 1.7B, 4B, 8B, 14B, 32B) e dois modelos MoE (30B-A3B, 235B-A22B). Os modelos MoE oferecem alta performance com custos de inferência reduzidos, ativando apenas uma fração dos parâmetros totais. Abaixo estão as especificações chave:

Modelos Densos Qwen3

| Modelo | Camadas | Heads (Q / KV) | Contexto |

|---|---|---|---|

| Qwen3-0.6B | 28 | 16 / 8 | 32K |

| Qwen3-1.7B | 28 | 16 / 8 | 32K |

| Qwen3-4B | 36 | 32 / 8 | 32K |

| Qwen3-8B | 36 | 32 / 8 | 128K |

| Qwen3-14B | 40 | 40 / 8 | 128K |

| Qwen3-32B | 64 | 64 / 8 | 128K |

Modelos MoE Qwen3

| Modelo | Camadas | Heads (Q / KV) | Especialistas (Total / Ativos) | Contexto |

|---|---|---|---|---|

| Qwen3-30B-A3B | 48 | 32 / 4 | 128 / 8 | 128K |

| Qwen3-235B-A22B | 94 | 64 / 4 | 128 / 8 | 128K |

Como o Qwen3 se compara a outros LLMs de ponta?

O Qwen3 demonstra forte competitividade em diversos benchmarks avaliativos. O modelo Qwen3-235B-A22B alcança resultados comparáveis a outros modelos de elite como DeepSeek-R1, o1, o3-mini, Grok-3 e Gemini-2.5-Pro, especialmente em tarefas de codificação, matemática e capacidades gerais.

Análises de 2025 indicam que até modelos menores como o Qwen3-30B-A3B superam modelos densos maiores (como QwQ-32B) com significativamente menos parâmetros ativos. Notavelmente, o Qwen3-4B rivaliza com a performance do Qwen2.5-72B-Instruct, evidenciando a eficiência da nova arquitetura e treinamento.

![Qwen3: O Novo Modelo de IA Híbrido para Raciocínio Profundo e Ação Rápida [2025] 9 Gráfico de benchmark comparando Qwen3-235B-A22B com outros LLMs de topo](https://rendageek.com.br/wp-content/uploads/2025/04/qwen3-235a22-scaled.jpg)

![Qwen3: O Novo Modelo de IA Híbrido para Raciocínio Profundo e Ação Rápida [2025] 10 Gráfico de benchmark comparando Qwen3-30B-A3B com outros LLMs](https://rendageek.com.br/wp-content/uploads/2025/04/qwen3-30a3-scaled.jpg)

Quais idiomas o Qwen3 suporta?

Uma das vantagens significativas do Qwen3 é seu amplo suporte multilíngue. Os modelos Qwen3 foram treinados para compreender e gerar texto em 119 idiomas e dialetos, um aumento considerável em relação às versões anteriores.

Esta capacidade robusta abre portas para aplicações globais e permite que usuários de diversas regiões linguísticas utilizem o poder desses modelos. Os idiomas suportados incluem famílias como:

- Indo-Europeia: Inglês, Português, Espanhol, Francês, Alemão, Russo, Hindi, etc.

- Sino-Tibetana: Chinês (Simplificado, Tradicional, Cantonês), Birmanês.

- Afro-Asiática: Árabe (diversos dialetos), Hebraico.

- Austronésia: Indonésio, Malaio, Tagalo, Javanês.

- Outras: Japonês, Coreano, Turco, Vietnamita, Tailandês, Finlandês, Swahili, e muitas mais.

Como posso começar a usar o Qwen3?

Iniciar o desenvolvimento com Qwen3 é facilitado pela sua disponibilidade em plataformas populares e suporte a diversas ferramentas. Você pode acessar os modelos Qwen3 (pré-treinados e pós-treinados) em plataformas como Hugging Face, ModelScope e Kaggle. Para implementação e uso, siga estes passos gerais:

- Escolha o Modelo: Selecione o modelo Qwen3 (denso ou MoE) adequado às suas necessidades de performance e recursos.

- Acesse a Plataforma: Baixe o modelo escolhido do Hugging Face, ModelScope ou Kaggle.

- Use Frameworks de Inferência: Para deployment, utilize frameworks como SGLang (`>=0.4.6.post1`) ou vLLM (`>=0.8.4`) que suportam Qwen3, incluindo o modo de raciocínio.

- Desenvolvimento Local: Para uso local, ferramentas como Ollama, LMStudio, MLX, llama.cpp e KTransformers são recomendadas.

- Explore o Código Exemplo: Utilize os snippets de código fornecidos (veja abaixo) para integrar o Qwen3 em seus projetos Python usando `transformers`.

- Experimente o Qwen Chat: Teste as capacidades do Qwen3 diretamente na interface web [chat.qwen.ai](https://chat.qwen.ai) ou no aplicativo móvel.

Como foi realizado o pré-treinamento do Qwen3?

O pré-treinamento do Qwen3 foi significativamente expandido, utilizando aproximadamente 36 trilhões de tokens, quase o dobro do Qwen2.5. Este vasto dataset abrange 119 idiomas e dialetos, coletado da web e de documentos PDF (com texto extraído via Qwen2.5-VL e qualidade aprimorada por Qwen2.5). Para enriquecer dados de matemática e código, foram gerados dados sintéticos (livros didáticos, Q&A, snippets de código) usando Qwen2.5-Math e Qwen2.5-Coder. O processo ocorreu em três estágios, conforme divulgado pela equipe em 2025:

- Estágio 1 (S1): Treinamento com +30T tokens e contexto de 4K para habilidades linguísticas básicas.

- Estágio 2 (S2): Foco em dados intensivos em conhecimento (STEM, código, raciocínio) com +5T tokens adicionais.

- Estágio 3 (S3): Extensão do comprimento de contexto para 32K/128K usando dados de alta qualidade e longo contexto.

Esses avanços resultaram em modelos base Qwen3 com performance equivalente ou superior a modelos base Qwen2.5 maiores, especialmente em STEM, codificação e raciocínio, com os modelos MoE alcançando performance similar aos densos Qwen2.5 com apenas 10% dos parâmetros ativos.

![Qwen3: O Novo Modelo de IA Híbrido para Raciocínio Profundo e Ação Rápida [2025] 11 Gráfico comparando a performance dos modelos base Qwen3 com os modelos base Qwen2.5 em diversas tarefas](https://rendageek.com.br/wp-content/uploads/2025/04/qwen3-base-1024x697.jpg)

Qual a metodologia de pós-treinamento para os Modos Híbridos?

Para desenvolver o modelo híbrido capaz de raciocínio passo a passo e respostas rápidas, a Qwen Team implementou um pipeline de treinamento robusto em quatro estágios. Este processo visa integrar as capacidades de pensamento profundo e resposta ágil de forma coesa. Os estágios, detalhados no anúncio de 2025, foram:

- Long Chain-of-Thought (CoT) Cold Start: Fine-tuning inicial com dados CoT longos e diversificados (matemática, código, lógica, STEM) para estabelecer habilidades de raciocínio fundamentais.

- Reforço de Aprendizagem (RL) Baseado em Raciocínio: Uso de RL com recompensas baseadas em regras para escalar recursos computacionais, aprimorando a exploração e explotação do modelo.

- Fusão do Modo de Pensamento: Integração das capacidades de não-pensamento (respostas rápidas) ao modelo pensador, usando uma combinação de dados CoT e dados de ajuste de instrução comuns gerados pelo modelo aprimorado no estágio 2.

- RL Geral: Aplicação de RL em mais de 20 tarefas de domínio geral (seguimento de instruções, formato, capacidades de agente) para fortalecer as capacidades gerais e corrigir comportamentos indesejados.

![Qwen3: O Novo Modelo de IA Híbrido para Raciocínio Profundo e Ação Rápida [2025] 12 Diagrama ilustrando o pipeline de pós-treinamento de quatro estágios do Qwen3](https://rendageek.com.br/wp-content/uploads/2025/04/post-training-1024x405.png)

Quais são as capacidades aprimoradas de agente do Qwen3?

O Qwen3 foi otimizado para tarefas de codificação e capacidades de agente, incluindo suporte fortalecido para MCP (Multi-Agent Collaboration Protocol). Isso significa que os modelos Qwen3 são mais eficazes em interagir com ferramentas, APIs e ambientes externos para realizar tarefas complexas.

A capacidade aprimorada de ‘tool calling’ permite que o Qwen3 utilize ferramentas definidas (como busca na web, execução de código, consulta de APIs) como parte de seu processo de raciocínio e resposta. Para facilitar o uso dessas capacidades, recomenda-se o uso do Qwen-Agent, que simplifica a definição e o uso de ferramentas com os modelos Qwen3.

Como usar os modos de pensamento dinamicamente (/think, /no_think)?

O Qwen3 oferece um mecanismo de ‘soft switch’ para controlar o modo de pensamento dinamicamente durante uma conversa, quando `enable_thinking=True`. Você pode adicionar as tags /think ou /no_think ao final das suas mensagens (user prompts ou system messages) para instruir o modelo a usar ou não o raciocínio explícito naquela interação específica. O modelo seguirá a instrução mais recente em conversas multi-turno.

python

# Exemplo de uso com a biblioteca transformers

from modelscope import AutoModelForCausalLM, AutoTokenizer

model_name = "Qwen/Qwen3-30B-A3B"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype="auto",

device_map="auto"

)

# Ativar modo pensamento por padrão (pode ser omitido se True for default)

prompt_1 = "Quantos 'r' tem em 'strawberries'?"

messages_1 = [

{"role": "user", "content": prompt_1}

]

text_1 = tokenizer.apply_chat_template(

messages_1,

tokenize=False,

add_generation_prompt=True,

enable_thinking=True # Modo pensamento ATIVADO (padrão)

)

# ... gerar resposta 1 ...

# Desativar modo pensamento para a próxima interação

prompt_2 = "E quantos 'r' tem em 'blueberries'? /no_think"

messages_2 = messages_1 + [{"role": "assistant", "content": "Resposta anterior..."}, {"role": "user", "content": prompt_2}]

text_2 = tokenizer.apply_chat_template(

messages_2, # Inclui histórico e a nova instrução com /no_think

tokenize=False,

add_generation_prompt=True

# enable_thinking não precisa ser setado aqui, a tag /no_think controla

)

# ... gerar resposta 2 (será mais rápida, sem raciocínio explícito) ...

# Reativar modo pensamento com tag

prompt_3 = "Tem certeza? /think"

messages_3 = messages_2 + [{"role": "assistant", "content": "Resposta anterior..."}, {"role": "user", "content": prompt_3}]

text_3 = tokenizer.apply_chat_template(

messages_3, # Inclui histórico e a nova instrução com /think

tokenize=False,

add_generation_prompt=True

)

# ... gerar resposta 3 (voltará a usar raciocínio explícito) ...

Como integrar o Qwen3 para tarefas de agente com Qwen-Agent?

Aproveitar as capacidades de agente do Qwen3 é simplificado com a biblioteca Qwen-Agent. Ela encapsula templates de chamada de ferramentas e parsers, reduzindo a complexidade do código. Você pode definir as ferramentas disponíveis via arquivo de configuração MCP, usar ferramentas integradas do Qwen-Agent ou integrar suas próprias ferramentas.

python

from qwen_agent.agents import Assistant

import os

# 1. Configurar LLM (apontando para seu endpoint Qwen3)

llm_cfg = {

'model': 'Qwen3-30B-A3B', # Ou o modelo Qwen3 específico que você está usando

# Exemplo usando endpoint local compatível com API OpenAI (via vLLM/SGLang)

'model_server': 'http://localhost:8000/v1', # Substitua pela URL do seu servidor

'api_key': 'EMPTY', # Chave API, se necessária

# Geração de configuração (opcional)

# 'generate_cfg': {

# 'thought_in_content': True, # Se o raciocínio vem junto com a resposta

# },

}

# 2. Definir Ferramentas

tools = [

# Exemplo usando servidor MCP para ferramentas de tempo e busca web

# {'mcpServers': {

# 'time': {

# 'command': 'uvx',

# 'args': ['mcp-server-time', '--local-timezone=Asia/Shanghai']

# },

# "fetch": {

# "command": "uvx",

# "args": ["mcp-server-fetch"]

# }

# }

# },

'code_interpreter', # Ferramenta integrada para execução de código Python

# Adicione outras ferramentas aqui (customizadas ou do Qwen-Agent)

]

# 3. Inicializar o Agente

bot = Assistant(llm=llm_cfg, function_list=tools)

# 4. Executar uma tarefa que requer ferramentas

messages = [{'role': 'user', 'content': 'Qual a data e hora atuais e calcule 5 elevado à 3ª potência?'}]

# Geração em streaming

full_response = ""

for response_chunk in bot.run(messages=messages):

print(response_chunk) # Processa os chunks da resposta

# A resposta final geralmente está no último chunk

final_output = response_chunk

print("\n--- Resposta Final Completa ---")

print(final_output)

Quais são os planos futuros para a família Qwen?

O Qwen3 representa um marco significativo na jornada em direção à Inteligência Artificial Geral (AGI) e Superinteligência Artificial (ASI). Os planos futuros incluem o aprimoramento contínuo dos modelos em múltiplas dimensões: refinar arquiteturas e metodologias de treinamento, escalar dados, aumentar o tamanho dos modelos, estender o comprimento do contexto, ampliar modalidades (além de texto) e avançar o RL com feedback ambiental para raciocínio de longo horizonte.

A equipe acredita na transição de uma era focada em treinar modelos para uma centrada em treinar agentes, prometendo avanços significativos que impactarão o trabalho e a vida cotidiana.

Ecossistema e Comunidade Qwen

O desenvolvimento do Qwen é impulsionado por uma comunidade crescente de colaboradores e parceiros. A Qwen Team agradece o apoio e convida mais organizações e indivíduos a se juntarem à comunidade para ajudar a moldar o futuro da IA de código aberto.

![Qwen3: O Novo Modelo de IA Híbrido para Raciocínio Profundo e Ação Rápida [2025] 13 Logos de parceiros e amigos da comunidade Qwen](https://rendageek.com.br/wp-content/uploads/2025/04/qwen3-logo-scaled.png)

Principais pontos

- Lançamento Qwen3: Nova família de LLMs de código aberto (Apache 2.0) com foco em performance e eficiência.

- Modos Híbridos: Capacidade única de alternar entre raciocínio profundo (Thinking Mode) e respostas rápidas (Non-Thinking Mode).

- Modelos Diversos: Inclui modelos densos (0.6B a 32B) e MoE eficientes (30B-A3B, 235B-A22B).

- Performance Competitiva: Benchmarks mostram resultados comparáveis aos melhores LLMs do mercado.

- Suporte Multilíngue: Compreende e gera texto em 119 idiomas e dialetos.

- Capacidades de Agente: Otimizado para ‘tool calling’ e interação com ambientes externos, com suporte via Qwen-Agent.

- Disponibilidade: Acessível via Hugging Face, ModelScope, Kaggle e compatível com SGLang, vLLM, Ollama, etc.

FAQ Estratégico sobre Qwen3

Respostas rápidas para perguntas comuns sobre a nova família de modelos Qwen3.

Sim, os modelos Qwen3 são disponibilizados sob a licença Apache 2.0, permitindo uso comercial e modificação. Esta licença de código aberto promove ampla adoção e inovação pela comunidade. Verifique sempre os termos exatos da licença para detalhes específicos de conformidade e atribuição ao usar os modelos em seus projetos.

A principal diferença reside na escala de treinamento (36T tokens vs 18T), na introdução dos modos de pensamento híbridos e na performance aprimorada. Modelos Qwen3 menores, como o 4B, podem igualar ou superar modelos Qwen2.5 maiores (72B), especialmente em tarefas STEM e de código, demonstrando maior eficiência e capacidade de raciocínio avançado.

Não necessariamente. A família Qwen3 inclui modelos menores como Qwen3-0.6B, 1.7B e 4B, projetados para serem executados em hardware mais modesto, incluindo GPUs de consumidor. Os modelos MoE (30B-A3B) também são eficientes, ativando apenas 3B parâmetros, reduzindo requisitos de VRAM em comparação com modelos densos de tamanho similar.

Sim, o Qwen3 foi explicitamente otimizado para tarefas de codificação. O pré-treinamento incluiu dados de código sintético gerados pelo Qwen2.5-Coder, e os benchmarks mostram forte performance em avaliações de codificação. Suas capacidades de agente também permitem interagir com ferramentas de execução de código como o ‘code_interpreter’.

O Modo Pensamento (Thinking Mode) geralmente resulta em maior latência e custo computacional, pois o modelo executa etapas de raciocínio adicionais. O Modo Não-Pensamento oferece respostas mais rápidas (menor latência) e menor custo, adequado para tarefas mais simples. O controle dinâmico via tags /think e /no_think permite otimizar esse trade-off por tarefa.

Conclusão

O lançamento do Qwen3 marca um passo importante na evolução dos modelos de linguagem grandes de código aberto. Com seus inovadores modos de pensamento híbridos, ampla gama de modelos (incluindo MoEs eficientes), suporte multilíngue robusto e capacidades de agente aprimoradas, o Qwen3 oferece uma plataforma poderosa e flexível para desenvolvedores e pesquisadores.

O compromisso com o código aberto sob a licença Apache 2.0 e a performance competitiva posicionam o Qwen3 como um forte concorrente no cenário da IA generativa em 2025. Explore os recursos e comece a construir com Qwen3 hoje mesmo.

![Qwen3: O Novo Modelo de IA Híbrido para Raciocínio Profundo e Ação Rápida [2025] 7 Banner de lançamento do Qwen3 LLM com elementos gráficos abstratos representando inteligência artificial e redes neurais.](https://rendageek.com.br/wp-content/uploads/2025/04/qwen3-banner.png)