QwenLong-L1 Revoluciona Raciocínio em Contextos Longos

Em meio aos avanços dos modelos de linguagem, o QwenLong-L1 da Alibaba surge como uma solução capaz de superar desafios críticos no raciocínio de contextos extensos. Lançado recentemente, o framework utiliza técnicas de reinforcement learning (RL) para ensinar os LLMs a processarem documentos complexos e com grande volume de informações. Este artigo explora os métodos de treinamento, resultados obtidos e as aplicações empresariais que podem se beneficiar dessa tecnologia.

O QwenLong-L1 apresenta uma abordagem multi-estágio que permite aos modelos de linguagem compreenderem e operarem sobre dados muito maiores do que os tradicionais 4.000 tokens, alcançando a notável marca de 120.000 tokens. A transformação começa com um processo de fine-tuning supervisionado que estabelece as bases para a compreensão contextual e se desenvolve através de um treinamento por fases, onde a complexidade e o volume das entradas aumentam gradativamente.

Tabela de conteúdos

Desafios do Raciocínio em Contextos Extensos

Tradicionalmente, os modelos de linguagem se destacam na análise de textos curtos, mas enfrentam sérias dificuldades quando expostos a documentos longos e densos. Os desafios estão no processamento e na extração de informações relevantes, onde a simples memorização dos dados internos não é suficiente. Ao trabalhar com grandes volumes de texto, os modelos precisam realizar um verdadeiro raciocínio em etapas, fazendo conexões e estabelecendo relações lógicas entre segmentos dispersos do conteúdo.

Estudos indicam que os modelos que utilizam reinforcement learning ajustado conseguem desenvolver uma espécie de “pensamento lento”, similar ao raciocínio humano, permitindo uma análise gradual e mais aprofundada. Entretanto, mesmo com essa abordagem, a escalabilidade para lidar com contextos extremamente longos continua sendo um grande desafio para a IA moderna.

A Abordagem Multi-Estágio do QwenLong-L1

Para enfrentar esses desafios, o QwenLong-L1 incorpora três etapas de treinamento:

- Warm-up Supervised Fine-Tuning (SFT): Nesta fase inicial, o modelo é treinado com exemplos práticos de raciocínio em contextos extensos, permitindo uma base sólida para posterior adaptação.

- Curriculum-Guided Phased RL: O treinamento é realizado em fases, com o tamanho dos documentos aumentando progressivamente. Este método previne instabilidades e garante uma transição suave para a manipulação de entradas maiores.

- Difficulty-Aware Retrospective Sampling: A fase final prioriza exemplos difíceis, incentivando o modelo a aprender com os casos mais desafiadores e a desenvolver estratégias de autoavaliação e correção.

Esse processo estruturado permite que o modelo não apenas memorize, mas estabeleça conexões entre diferentes partes do documento, realizando um verdadeiro raciocínio multi-etapas que se assemelha ao pensamento humano.

Avaliação e Resultados

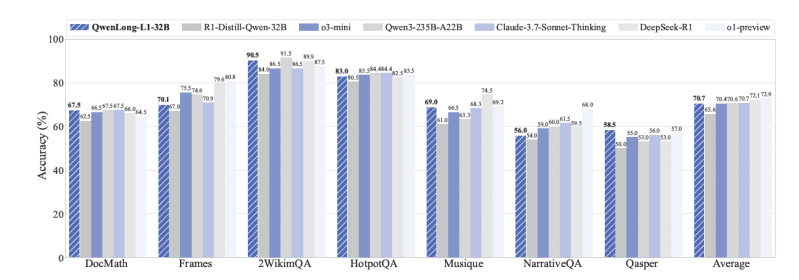

Os testes realizados com o QwenLong-L1 concentraram-se principalmente na tarefa de Document Question Answering (DocQA), que simula a necessidade de responder questões complexas a partir de documentos extensos. Em experimentos realizados em sete benchmarks diferentes, o modelo QwenLong-L1-32B demonstrou resultados comparáveis a alguns dos melhores modelos disponíveis atualmente, como o Anthropic’s Claude-3.7 Sonnet Thinking e superou outros modelos concorrentes, inclusive alguns da OpenAI.

Outro aspecto importante dos testes foi a capacidade do modelo de se auto-corrigir. Ao apresentar técnicas de “backtracking” e verificação própria, o QwenLong-L1 mostrou habilidades avançadas de identificar e corrigir erros no próprio raciocínio, garantindo respostas mais precisas e fundamentadas.

Aplicações Empresariais e Implicações Futuras

As aplicações do QwenLong-L1 se estendem a diversos setores, especialmente onde a análise de grandes volumes de dados é essencial. No setor jurídico, por exemplo, o modelo pode ser utilizado para examinar contratos complexos e detectar inconsistências ou riscos. No mundo financeiro, ele tem o potencial de transformar a análise de relatórios anuais e documentos de investimentos, auxiliando na tomada de decisões estratégicas e na avaliação de riscos.

Outro setor beneficiado é o de atendimento ao cliente. Serviços que lidam com históricos extensos de interação podem utilizar o QwenLong-L1 para identificar padrões de comportamento, oferecer respostas precisas e personalizadas, e até antecipar demandas dos clientes com base na análise detalhada de seus relatos.

Além disso, a abordagem de treinamento com RL híbrido, que combina critérios baseados em regras com a avaliação do próprio modelo (LLM-as-a-judge), abre caminho para futuras pesquisas. Essa metodologia poderá ser adaptada e melhorada, trazendo novas nuances à maneira como as IAs lidam com a vasta informação disponível na atual era digital.

Validação, Evidências e a Importância do Grounding

A validação dos resultados do QwenLong-L1 reforça a importância de técnicas de grounding para o raciocínio de contextos longos. Ao relacionar respostas a partes específicas do texto, o modelo demonstra uma melhor compreensão e a capacidade de justificar suas respostas. Essa característica é crucial em aplicações críticas, onde a transparência e a rastreabilidade das decisões são fundamentais.

Estudos detalhados disponíveis no paper original, assim como os benchmarks realizados, evidenciam que o método de sampling baseado na dificuldade e o treinamento supervisionado inicial são determinantes para o sucesso do framework. Tais evidências colocam o QwenLong-L1 como uma das soluções mais promissoras para o processamento de documentos extensos, sugerindo um futuro onde a IA possa ser aplicada a uma variedade maior de problemas de análise e interpretação textual.

Contexto Expandido e Considerações Finais

Ao acompanhar o desenvolvimento dos modelos de IA, é fundamental considerar não apenas a evolução técnica, mas também as implicações para os usuários finais e para a sociedade. A capacidade de lidar com textos extensos abre novas possibilidades, como a automatização de análises jurídicas, financeiras e de atendimento, podendo transformar a maneira como interagimos com a informação.

Embora ainda existam desafios a serem superados, como a estabilidade do treinamento em ambientes com contextos realmente massivos, o QwenLong-L1 se destaca como um divisor de águas na evolução dos LLMs. Ele demonstra que, com estratégias de treinamento adequadas, é possível expandir significativamente as fronteiras do que as IAs podem compreender e processar, abrindo caminho para inovações que trarão mais eficiência e precisão para diversas áreas do conhecimento.

Em resumo, a inovação trazida pelo QwenLong-L1 não apenas melhora o desempenho em tarefas de raciocínio com textos longos, mas também aponta para um futuro onde a inteligência artificial se torna uma ferramenta indispensável para resolver problemas complexos e fornecer insights aprofundados que influenciam decisões estratégicas nas organizações.

Perguntas Frequentes sobre QwenLong-L1

O que é o QwenLong-L1?

O QwenLong-L1 é um framework de reinforcement learning desenvolvido pela Alibaba que permite a modelos de linguagem processar e raciocinar sobre contextos extremamente longos.

Como o QwenLong-L1 supera as limitações dos LLMs tradicionais?

Utilizando um treinamento multi-estágio que inclui fine-tuning supervisionado e fases progressivas de RL, o QwenLong-L1 adapta a capacidade dos modelos para lidar com textos com até 120.000 tokens.

Quais são as aplicações práticas desta tecnologia?

O QwenLong-L1 pode ser aplicado em análises jurídicas, financeiras, atendimento ao cliente e outros setores que exigem processamento de grandes volumes de dados textuais.

Com a crescente complexidade dos dados e a necessidade de respostas precisas mesmo em documentos extensos, o QwenLong-L1 representa uma evolução significativa no campo da inteligência artificial. Seu desenvolvimento aponta para uma nova era onde a IA pode finalmente entender a riqueza de informações presentes em textos longos, contribuindo para decisões mais embasadas e estratégicas em variados setores.

Considerações Finais

O QwenLong-L1 demonstra como inovações em treinamento e adaptação de modelos de linguagem podem transformar desafios em oportunidades. Através da combinação de técnicas supervisionadas e de reinforcement learning, este framework não apenas amplia a capacidade de raciocínio dos LLMs, mas também abre novas possibilidades para aplicações empresariais e acadêmicas. Com sua capacidade de processar contextos imensamente longos, a tecnologia promete impactar diversos setores, promovendo uma compreensão mais profunda e detalhada de grandes volumes de informação.

À medida que a pesquisa e o desenvolvimento avançam, espera-se que metodologias como a do QwenLong-L1 sejam aperfeiçoadas e adaptadas para resolver ainda mais desafios complexos, consolidando a inteligência artificial como parceira estratégica indispensável na era digital.