Falhas nos Sistemas RAG: Contexto Suficiente da Google

Descubra os desafios e soluções para os sistemas RAG em IA. Um estudo recente do Google propõe a abordagem de contexto suficiente para melhorar a exatidão e confiabilidade das respostas dos grandes modelos de linguagem em aplicações empresariais.

Os sistemas baseados em Retrieval Augmented Generation (RAG) têm ganhado destaque por sua capacidade de integrar informações externas aos grandes modelos de linguagem (LLMs). Contudo, apesar do avanço na tecnologia, diversas inconsistências e desafios persistem, principalmente quando o contexto fornecido não é totalmente adequado para responder a uma consulta. O recente estudo divulgado por pesquisadores do Google apresenta a ideia inovadora de contexto suficiente, um método que visa identificar se a informação disponível é capaz de fundamentar uma resposta correta e, caso contrário, estimular o modelo a abster-se ou pedir mais dados.

Tabela de conteúdos

Desafios Persistentes dos Sistemas RAG

Apesar de os sistemas RAG serem essenciais para aplicações que exigem veracidade e exatidão, eles ainda sofrem com problemas sérios. Muitas vezes, os modelos apresentam confiança excessiva mesmo quando o contexto é insuficiente, levando à chamada alucinação – respostas imprecisas ou até erradas, que podem afetar decisões críticas em ambientes empresariais.

A pesquisa ressalta que os modelos devem ser capazes de diferenciar casos em que o contexto é suficiente — isto é, possui todas as informações necessárias para responder a uma pergunta — daqueles em que a informação é parcial, contraditória ou insuficiente. Esse cenário é especialmente relevante para aplicações reais, onde a existência de uma resposta incorreta pode gerar mal-entendidos ou decisões equivocadas.

A Abordagem: Contexto Suficiente

O estudo do Google introduz a classificação do contexto em duas categorias:

- Contexto Suficiente: quando a informação apresentada permite uma resposta definitiva.

- Contexto Insuficiente: quando faltam dados ou a informação se mostra ambígua e incompleta.

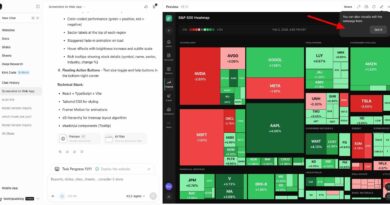

Para automatizar a avaliação sobre a suficiência do contexto, os pesquisadores desenvolveram um sistema denominado “autorater”, que utiliza um LLM para rotular automaticamente os exemplos de consulta e contexto. Os testes realizados demonstraram que, mesmo utilizando poucos exemplos (1-shot), o modelo Gemini 1.5 Pro do Google mostrou excelentes resultados em termos de precisão e F1 score.

Resultados e Principais Descobertas

Entre as descobertas do estudo, destaca-se que os modelos tendem a exibir maior exatidão quando o contexto é classificado como suficiente. Contudo, mesmo nestes casos, a tendência a alucinar permanece, ou seja, o modelo gera respostas mesmo diante da possibilidade de faltar informações complementar. Em situações onde o contexto se mostra insuficiente, os modelos ainda assim podem apresentar altos índices de alucinação ou, em alguns casos, abstinência parcial.

Um aspecto notável da pesquisa foi a constatação de que, em determinadas situações, os modelos conseguem fornecer respostas corretas mesmo quando o contexto não é completamente adequado. Isso ocorre porque o LLM utiliza sua base de conhecimento pré-treinada para complementar lacunas, utilizando pistas contextuais para racionalizar a resposta. Assim, a integração do contexto com o conhecimento paramétrico se mostra vital para a precisão global do sistema.

Estratégias para Reduzir Alucinações e Melhorar a Precisão

O problema da alucinação – onde o modelo gera respostas imprecisas em função da confiança indevida em um contexto parcial – levou os pesquisadores a explorarem estratégias de geração seletiva. Essa abordagem propõe o uso de um modelo de intervenção menor que decide se o LLM principal deve responder ou se deve abstê-lo. Dessa forma, é possível criar um equilíbrio entre a precisão e a cobertura das respostas, priorizando a exatidão sempre que a informação for falha.

Uma tática adicional abordada no estudo envolveu o ajuste fino (fine-tuning) dos modelos através do treinamento com exemplos onde a resposta correta foi propositalmente substituída por um “Não sei” quando o contexto era insuficiente. Embora essa técnica tenha levado a uma elevação na taxa de respostas corretas, o fenômeno da alucinação continuou a ser um desafio a ser superado, ressaltando a necessidade de novas pesquisas e estratégias.

Aplicações Práticas em Ambientes Empresariais

Para empresas que desejam implementar sistemas RAG robustos em seus ambientes internos, como bases de conhecimento ou assistentes virtuais para suporte ao cliente, a classificação do contexto desempenha um papel crucial. A metodologia proposta sugere a coleta de um conjunto de dados de pares de consulta e contexto, seguido pelo uso do autorater para classificar cada exemplo. Essa etapa permite uma análise detalhada da proporção de contextos suficientes versus insuficientes, que pode indicar a qualidade geral da base de dados utilizada no sistema.

Ao estratificar as respostas do modelo com base na suficiência do contexto, as equipes de desenvolvimento podem identificar lacunas e aprimorar tanto os mecanismos de recuperação quanto as estratégias de integração do conhecimento pré-existente. Essa abordagem não só melhora a precisão das respostas, mas também oferece uma métrica adicional para o desempenho do sistema, possibilitando ajustes finos e monitoramento contínuo.

Implicações para o Futuro dos Sistemas RAG

O conceito de “contexto suficiente” apresentado pelo estudo abre caminho para uma nova geração de sistemas RAG, onde o valor das informações externas é mensurado não apenas pela sua presença, mas também pela sua qualidade e relevância para a consulta. Esse entendimento refina o processo de tomada de decisão do modelo, permitindo que este priorize a exatidão em detrimento da simples geração de uma resposta.

Além disso, a capacidade de combinar o conhecimento paramétrico dos LLMs com a recuperação de dados externos pode melhorar significativamente a confiabilidade dos sistemas de IA. Ao reconhecer quando um contexto é insuficiente, o modelo pode evitar erros que, em ambientes empresariais, poderiam levar a prejuízos financeiros ou à perda de confiança dos usuários.

Ao adotar essas novas práticas, empresas poderão desenvolver soluções mais seguras e robustas, adequadas a cenários onde a precisão da informação é imprescindível. A integração adequada entre recuperação e geração de conteúdo não só aprimora a performance dos modelos, mas também contribui para o avanço da inteligência artificial aplicada a negócios e processos críticos.

Considerações Finais

O estudo do Google sobre o uso de “contexto suficiente” em sistemas RAG evidencia a complexidade envolvida em equilibrar a recuperação e a geração de informações em grandes modelos de linguagem. Ao abordar diretamente os desafios das alucinações e da confiança excessiva, os pesquisadores oferecem insights valiosos para o desenvolvimento de ferramentas mais precisas e confiáveis em ambientes empresariais. Essa abordagem inovadora tem o potencial de redefinir a forma como as empresas interagem com a IA, promovendo sistemas que não apenas geram respostas, mas que também são capazes de reconhecer suas próprias limitações.

Enquanto as pesquisas continuam a evoluir, a implementação de técnicas como a geração seletiva e o ajuste fino pode representar um grande avanço para a segurança e eficácia dos modelos de IA. A classificação do contexto, em última análise, torna-se uma métrica essencial para determinar a viabilidade de respostas automáticas e para melhorar a experiência do usuário final.

A medida que as empresas incorporam essas novas práticas, a tendência é que os sistemas RAG se tornem cada vez mais integrados e precisos, abrindo caminho para aplicações mais sofisticadas e confiáveis no campo da inteligência artificial. O desafio de reduzir alucinações e oferecer respostas de alta qualidade continuará a impulsionar pesquisas e inovações, marcando um importante avanço para o futuro da IA empresarial.

Perguntas Frequentes

O que é um sistema RAG?

Um sistema RAG (Retrieval Augmented Generation) integra informações externas com a geração de texto por LLMs, visando respostas mais precisas.

Como o conceito de ‘contexto suficiente’ melhora a performance do modelo?

Ao classificar se o contexto possui todas as informações necessárias, o modelo decide de forma mais segura se deve responder ou abstiver-se, reduzindo alucinações.

Qual a importância de reduzir alucinações em sistemas empresariais?

Reduzir alucinações evita a geração de respostas imprecisas, aumentando a confiabilidade e a segurança das aplicações em ambientes críticos.

Como as empresas podem aplicar essa abordagem?

Elas podem coletar e classificar pares de consulta-contexto usando ferramentas como autoraters e ajustar os modelos para que reconheçam lacunas de informação antes de responder.

As perguntas frequentes acima ajudam a esclarecer os pontos chave do estudo, além de oferecer uma visão prática sobre como transformar essas descobertas em melhorias reais nos sistemas de IA empresarial.

Conclusão

O avanço dos sistemas RAG, impulsionado pela integração de dados externos e conhecimento prévio dos modelos, mostra que o desafio não está apenas em recuperar informações, mas em avaliá-las com precisão. Ao adotar o conceito de contexto suficiente, empresas e desenvolvedores podem aprimorar o desempenho de seus modelos e reduzir os riscos associados às alucinações. Essa abordagem representa um passo importante para a criação de IA mais segura, confiável e adaptada aos desafios do mundo real. Com a evolução contínua das técnicas e a implementação de novas estratégias, o futuro dos sistemas RAG promete ser cada vez mais robusto e eficaz na resolução de problemas complexos.