Deepfakes de áudio em tempo real: vishing já é real

Um marco na segurança cibernética: deepfakes de áudio em tempo real tornaram-se viáveis e convincentes. Um estudo recente da NCC Group mostrou que é possível clonar e reproduzir, ao vivo, a voz de uma pessoa com baixa latência, usando ferramentas acessíveis e hardware comum. A técnica potencializa o chamado deepfake vishing (voice phishing), especialmente quando combinada com caller ID spoofing, e exige novas práticas de autenticação para além de voz e vídeo. A seguir, entenda o que mudou, os limites, os riscos e como se proteger.

Tabela de conteúdos

deepfakes de audio em tempo real: O que aconteceu e por que importa

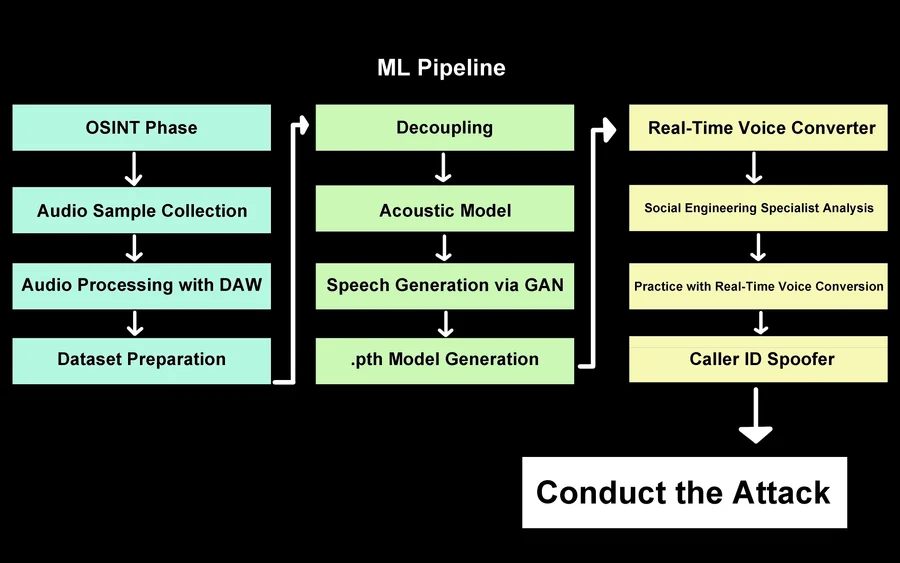

A NCC Group, consultoria de segurança, descreveu um fluxo que permite imitar, em tempo real, a voz de um alvo. Após um breve treinamento do modelo, o operador aciona um botão em uma interface web e a transformação de voz começa sem atrasos perceptíveis. No relatório, a equipe afirma ter realizado ligações, com consentimento de clientes, combinando o transformador de voz com caller ID spoofing. Segundo Pablo Alobera, managing security consultant, “na maioria das vezes, a pessoa do outro lado acreditou que éramos realmente quem pretendíamos imitar”.

Há ainda um exemplo de áudio que demonstra a naturalidade alcançada mesmo quando o microfone de entrada é simples (como os embutidos em notebooks e smartphones):

“Você clica em iniciar e começa a funcionar.”

Pablo Alobera, NCC Group

Um detalhe relevante: o protótipo foi montado com ferramentas de código aberto e hardware disponível no mercado. O melhor desempenho vem com GPU dedicada, mas até uma estação móvel com GPU Nvidia RTX A1000 (um modelo de entrada para workstations) gerou a voz com cerca de meio segundo de atraso, o que é aceitável em conversa telefônica.

Como a clonagem de voz em tempo real funciona

Embora a NCC Group não tenha liberado o código, o princípio por trás do sistema combina três pilares que evoluíram muito desde 2020: (1) modelos de conversão de voz (voice conversion) capazes de mapear timbre e prosódia, (2) síntese neural de fala (neural TTS) com latências baixas, e (3) otimizações de pipeline (captura, processamento e reprodução) para reduzir jitter e garantir estabilidade. O resultado é uma voz sintética que acompanha a fala do operador quase instantaneamente, com poucas quebras e entonação convincente.

Empresas como a ElevenLabs já ofereciam clonagem de voz de alta qualidade, mas tipicamente em modo assíncrono (você envia um texto ou áudio e recebe o resultado depois). A novidade aqui é a execução em tempo real, que elimina a necessidade de pré-gravação e torna a conversa livre, dinâmica e persuasiva — uma mudança crítica para golpes por telefone.

Deepfake vishing: vetor de ataque e táticas

No vishing, criminosos se passam por executivos, fornecedores, profissionais de suporte ou familiares para induzir ações precipitadas: liberar pagamentos, fornecer códigos de autenticação, instalar software, ou compartilhar dados confidenciais. Ao combinar a voz clonada com caller ID spoofing, o contexto da chamada parece legítimo, reduzindo a suspeita da vítima. O próprio teste da NCC Group mostra que, quando a identidade visual e sonora se alinham, a taxa de sucesso sobe drasticamente.

- Use autenticação fora de banda (por exemplo, confirme via canal diferente antes de aprovar pedidos sensíveis).

- Implemente senhas de uso único ou palavras-sinal para validação verbal entre equipes.

- Treine times para reconhecer pressão e urgência anormais como red flags.

- Bloqueie alterações críticas de cadastro por telefone; exija fluxos com múltiplas aprovações.

- Atualize playbooks de resposta e registre chamadas suspeitas para análise.

E o vídeo? Quão perto estamos do tempo real

Em paralelo, o ecossistema de video deepfakes passou por salto qualitativo graças a modelos recentes como o WAN 2.2 Animate (Alibaba) e o Gemini Flash 2.5 Image (Google, também apelidado de “Nano Banana”). Se ontem eram melhores com celebridades, hoje conseguem transfigurar praticamente qualquer rosto e corpo em diversos cenários. Ainda assim, a qualidade ao vivo não atinge o mesmo patamar do áudio: persistem pistas como o descompasso entre expressão facial e emoção da fala.

“Se a pessoa soa empolgada mas o rosto está sem emoção, é falso.”

Trevor Wiseman, The Circuit

Ainda que os sinais de manipulação existam, a regra prática é preocupante: a maioria das pessoas será enganada, a maior parte do tempo, por composições convincentes. Por isso, empresas e indivíduos precisam migrar a verificação de identidade para métodos que não dependam de voz ou imagem.

Limitações atuais e sinais de alerta

| Aspecto | Áudio em tempo real | Vídeo em tempo real |

|---|---|---|

| Latência | ~0,5 s aceitável em ligações | Ainda alta para qualidade premium |

| Qualidade | Voz natural e coerente | Expressões e sincronia ainda falham |

| Ferramentas | Pipeline com voice conversion/TTS | Modelos como WAN 2.2, Gemini 2.5 |

| Sinais de alerta | Pressa e pedidos fora de rotina | Olhar “vidrado”, lábios desincronizados |

Como se proteger agora

Mitigar o risco exige combinar tecnologia, processo e cultura. Ferramentas de detecção de deepfake em tempo real evoluem, mas ainda não são infalíveis. O mais eficaz, no curto prazo, é reduzir a confiança em canais vulneráveis (voz/vídeo) para decisões sensíveis e padronizar rituais de validação que independerão da aparência ou do som do interlocutor.

- Defina palavras-sinal rotativas por equipe e projeto.

- Exija confirmação por segundo canal autenticado para solicitações financeiras e de acesso.

- Ative travas administrativas contra mudanças por telefone (dados bancários, e-mails, limites).

- Eduque o time com simulações de vishing e feedback contínuo.

- Mapeie fornecedores que manuseiam pagamentos e acesso; imponha checklists antifraude.

Do lado técnico, equipes de TI podem explorar marca d’água (watermarking) de conteúdo gerado, verificação de origem (provenance) com assinaturas criptográficas e soluções de liveness multimodal (desafios dinâmicos que verificam resposta humana). Em paralelo, acompanhe atualizações de fabricantes de GPU e frameworks de IA que melhoram desempenho de inferência — o mesmo avanço que facilita ataques também abre espaço para novas defesas.

Pontos-chave

- Deepfakes de áudio em tempo real já são práticos com hardware acessível.

- Vishing com caller ID spoofing aumenta a taxa de sucesso de golpes.

- Vídeo deepfake avança, mas ainda falha no live de alta qualidade.

- Autenticação fora de banda e palavras-sinal são medidas imediatas.

O que é deepfake vishing e por que é perigoso?

Resposta direta: vishing é golpe por voz com deepfake em tempo real. Expansão: criminosos clonam a voz de alguém conhecido e ligam fingindo ser essa pessoa, pedindo transferências, senhas ou acessos. Com baixa latência e spoofing do número, a fraude soa legítima. Validação: a NCC Group demonstrou a técnica com alto índice de sucesso em testes controlados.

Como reconhecer um deepfake de áudio ao telefone?

Resposta direta: desconfie de urgência e pedidos fora de rotina. Expansão: sinais incluem mudanças sutis de ritmo, respostas atrasadas, insistência em atalhos e pressão temporal. Validação: use palavra-sinal e confirme por um segundo canal autenticado antes de qualquer ação sensível.

Vídeo deepfake em tempo real já é tão bom quanto o áudio?

Resposta direta: ainda não. Expansão: modelos como WAN 2.2 Animate e Gemini Flash 2.5 Image geram vídeos impressionantes, mas sofrem com sincronia facial e emoção ao vivo. Validação: especialistas apontam que expressões sem emoção coerente continuam sendo um indício de falsificação.

Quais medidas imediatas adotar nas empresas?

Resposta direta: crie autenticação fora de banda. Expansão: institua palavras-sinal, fluxos de aprovação, bloqueios administrativos por telefone e simulações periódicas de vishing. Validação: políticas claras e auditorias reduzem drasticamente o sucesso de engenharia social.

Quais ferramentas e recursos posso acompanhar?

Resposta direta: combine detecção e políticas. Expansão: monitore soluções de detecção de deepfakes, watermarking e verificação de origem, além de boas práticas de segurança cibernética. Validação: relatórios de grupos como a NCC Group e guias de provedores confiáveis ajudam a atualizar controles.

Considerações finais

O salto para deepfakes de áudio em tempo real muda a dinâmica da confiança digital. A partir de agora, “ouvir para crer” não é mais suficiente — nem em chamadas com vozes familiares. Enquanto a detecção evolui, a defesa mais eficaz é processual: validar por múltiplos canais, desacelerar decisões críticas e padronizar rituais antifraude. Em paralelo, acompanhe a evolução dos video deepfakes e atualize seus protocolos: a linha entre real e sintético está ficando cada vez mais tênue.