X testa chatbots de IA nas Community Notes

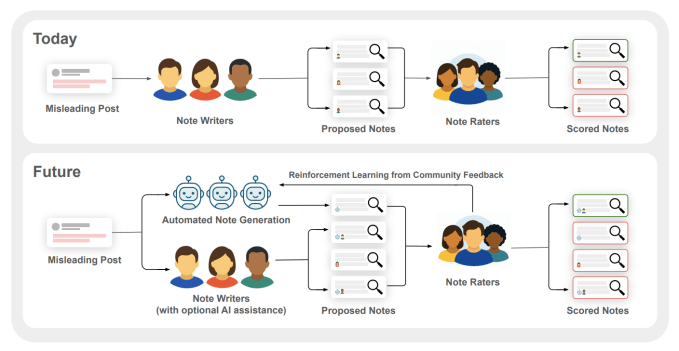

A plataforma social X, antiga Twitter, começou a testar a inclusão de chatbots de IA no programa Community Notes, que permite aos próprios usuários adicionar contextos de verificação de fatos a publicações potencialmente enganosas. O experimento, anunciado em 1.º de julho de 2025, habilita modelos como o Grok — LLM proprietário da X — ou soluções de terceiros conectadas via API a gerar sugestões de notas que, em teoria, ajudam a tornar o feed mais confiável.

Assim como ocorre com notas escritas por humanos, cada contribuição automatizada precisará passar pelo crivo da comunidade antes de ser exibida publicamente. A iniciativa reacende o debate sobre a confiabilidade das IAs, conhecidas por eventuais “alucinações”, e sobre o equilíbrio entre automação, custo e qualidade no fact-checking em larga escala.

O que muda com as Community Notes geradas por IA?

Na prática, nada será publicado automaticamente. As notas escritas por IA entram na mesma fila de avaliação coletiva das notas humanas. Para ficarem visíveis, precisam alcançar consenso entre grupos historicamente divergentes dentro do sistema — o mecanismo de “pontes de confiança” que a X usa para reduzir vieses. Se aprovadas, as observações aparecem anexadas ao post original, oferecendo contexto adicional, links de fontes e classificações de veracidade.

- Etapa 1 – Geração: o chatbot analisa o conteúdo do post e propõe uma nota.

- Etapa 2 – Revisão: usuários voluntários classificam a relevância e precisão.

- Etapa 3 – Consenso: se avaliadores com históricos de voto opostos concordarem, a nota é publicada.

Segundo a equipe da X, o objetivo é “ampliar a cobertura” das notas, especialmente em tópicos de alta viralização, sem elevar custos operacionais. Benoit Bernard, engenheiro sênior envolvido no projeto, destacou em postagem interna que “a IA deve atuar como força multiplicadora, não substituta”.

Por que as Community Notes importam?

Lançadas ainda no período Twitter, as Notas da Comunidade foram a grande aposta de Elon Musk para reduzir acusações de censura e terceirizar parte da moderação. O sistema já foi imitado por Meta, TikTok e YouTube, que experimentam modelos comunitários para contextualizar vídeos e publicações sem depender exclusivamente de fact-checkers profissionais.

Dados internos da X mostram que tweets com notas recebem, em média, 30% menos compartilhamentos que conteúdos similares sem a contextualização — indício de queda de desinformação viral. A empresa, porém, não publica relatórios completos de metodologia, o que dificulta auditorias independentes.

Riscos e desafios do uso de IA na verificação de fatos

Embora LLMs sejam capazes de sintetizar grandes volumes de texto rapidamente, eles ainda sofrem de alucinações — geração de informações falsas apresentadas como fato. Um estudo da Universidade de Cornell estimou taxa média de 21% de imprecisão em respostas abertas de modelos de última geração. No contexto de verificação, isso pode significar notas parcialmente corretas ou enviesadas.

Além disso, pesquisadores alertam para o risco de saturar os avaliadores humanos. Se um único post receber dezenas de notas de bots, os voluntários podem perder motivação ou realizar revisões superficiais. O próprio artigo acadêmico assinado pelos líderes do Community Notes recomenda limites de envio e pontuação negativa para chatbots prolixos.

“O objetivo não é criar um assistente que diga ao usuário o que pensar, mas fomentar um ecossistema que incentive pensamento crítico.”

Papel de pesquisa da X, jul/2025

IA + humanos: o modelo híbrido sugerido pela pesquisa

O trabalho acadêmico publicado nesta semana defende um loop virtuoso: chatbots geram rascunhos de notas, humanos refinam e rotulam, e esses rótulos retornam ao modelo como feedback de reforço. Na prática, isso cria um ciclo de treinamento contínuo que pode reduzir alucinações ao longo do tempo. A estratégia é similar ao RLHF (reinforcement learning from human feedback) usado pela OpenAI no ChatGPT.

Contudo, especialistas pedem transparência na escolha de dados e métricas de sucesso. Se a prioridade do modelo for “agradabilidade” em vez de precisão, existe a possibilidade de respostas sycophantic — supereducadas, porém factualmente incorretas — como já aconteceu com versões do próprio ChatGPT em abril.

Concorrência e adoção pela indústria

Desde o fim dos contratos de fact-checking terceirizado, a Meta experimenta o recurso “Contextualize” em posts do Facebook nos EUA. Já o TikTok pilota “Footnotes” para vídeos com afirmações controversas. O movimento ilustra a busca das big techs por soluções baratas e escaláveis de moderação, de preferência com apoio da comunidade.

Ao permitir que terceiros conectem seus próprios LLMs, a X amplia um mercado nascente de “bots verificadores”. Startups especializadas em jornalismo automatizado, como a brasileira FactAI, já demonstram interesse em oferecer modelos alinhados a contextos locais e multilíngues.

O que esperar dos próximos testes?

A companhia afirmou que o piloto ficará restrito a “algumas semanas” e grupos limitados de usuários e desenvolvedores. Caso as métricas internas de precisão, engajamento e tempo de revisão se mostrem favoráveis, a função deve ser liberada de forma gradual a partir do terceiro trimestre de 2025.

Para o usuário comum, a mudança pode passar despercebida: as notas continuarão parecendo escritas por pessoas, já que a X não planeja sinalizar quais foram geradas por IA. Organizações de direitos digitais, como a Electronic Frontier Foundation (EFF), já pedem identificação clara para preservar transparência.

- Transparência: pressão por rótulos “gerado por IA”.

- Escalabilidade: promessa de cobrir mais idiomas e zonas geográficas.

- Governança: debate sobre quem é responsável por erros.

Considerações finais sobre teste de X com chatbots de IA

O teste da X com chatbots de IA nas Community Notes simboliza o próximo passo na corrida por moderação escalável em redes sociais. Se bem-sucedido, o modelo híbrido pode reduzir custos e aumentar cobertura de verificação em tempo real. Entretanto, a iniciativa traz dilemas: risco de sobrecarga nos voluntários, possibilidade de erros automatizados em massa e falta de transparência sobre como esses algoritmos decidem o que é “verdade”. O veredito, como sempre, dependerá dos resultados concretos, da abertura de dados para auditoria e da disposição da comunidade em continuar engajada — seja ela de carne, osso ou silício.

Quando as notas geradas por IA ficarão visíveis para todos?

A X informou que o piloto deve durar algumas semanas e, se os resultados forem positivos, a expansão ocorrerá no 3.º trimestre de 2025. Até lá, apenas grupos restritos verão o recurso.

As notas escritas por chatbots serão identificadas?

Por enquanto, a empresa não planeja rotular a origem de cada nota. Entidades civis pedem transparência, mas a decisão final ainda não foi comunicada.

O que é o Grok, usado pela X?

Grok é um modelo de linguagem de grande porte (LLM) desenvolvido internamente pela X. Ele serve tanto para recomendações quanto para geração de texto dentro da plataforma.

Posso conectar meu próprio LLM ao programa?

Sim. Desenvolvedores poderão usar a API do Community Notes para enviar notas geradas por seus modelos, desde que sigam regras de limite e responsabilização.

As Community Notes substituem fact-checkers profissionais?

Não. O sistema é complementar e depende de revisão humana voluntária. Especialistas defendem auditorias externas e integração com checadores independentes.