Google Gemini imagem recebe upgrade nano-banana

Google lança hoje, globalmente, um upgrade no modelo de imagem do Gemini 2.5 Flash Image, com edição mais precisa por linguagem natural e preservação de rostos e detalhes. A atualização chega ao app do Gemini e às plataformas Gemini API, Google AI Studio e Vertex AI nesta terça-feira (26/08/2025). Em disputa direta com as ferramentas visuais do ChatGPT, o Google mira reduzir a distância de uso: o ChatGPT soma mais de 700 milhões de usuários semanais, enquanto o Gemini reportou 450 milhões de usuários mensais em julho.

Tabela de conteúdos

O que muda no Gemini 2.5 Flash Image

O novo modelo de imagem do Gemini foi desenhado para executar edições finas, com foco em manter a consistência de pessoas, animais e objetos. Em tarefas em que rivais ainda falham — como alterar a cor de uma camisa sem deformar o rosto ou o fundo — o 2.5 Flash Image promete outputs mais limpos e usáveis. A edição é guiada por prompts em linguagem natural e funciona tanto para ajustes pontuais (cor, textura, luz) quanto para manipulações composicionais (inserir ou fundir elementos entre fotos).

Segundo Nicole Brichtova, líder de produto de modelos visuais no Google DeepMind, o Google está “elevando a qualidade visual e a capacidade do modelo de seguir instruções”. Em entrevista, ela destacou que as edições ficaram mais naturais e que “os resultados são utilizáveis para o que você quiser”.

“Estamos realmente avançando a qualidade visual, assim como a habilidade do modelo de seguir instruções.”

Nicole Brichtova, Google DeepMind

Por que isso importa na corrida da IA

Modelos de imagem tornaram-se um campo de batalha estratégico. O lançamento do gerador nativo de GPT-4o, em março, impulsionou o uso do ChatGPT com uma onda de memes estilizados e composições de alta fidelidade. Para acompanhar, a Meta anunciou uma parceria de licenciamento com a Midjourney, enquanto a Black Forest Labs, apoiada pela a16z, segue bem colocada em benchmarks com a série FLUX. A ofensiva do Google com o Gemini 2.5 Flash Image é uma tentativa clara de equiparar recursos e reconquistar tração.

| Plataforma | Indicador divulgado | Periodicidade |

| ChatGPT | 700 milhões de usuários | semanal |

| Gemini | 450 milhões de usuários | mensal |

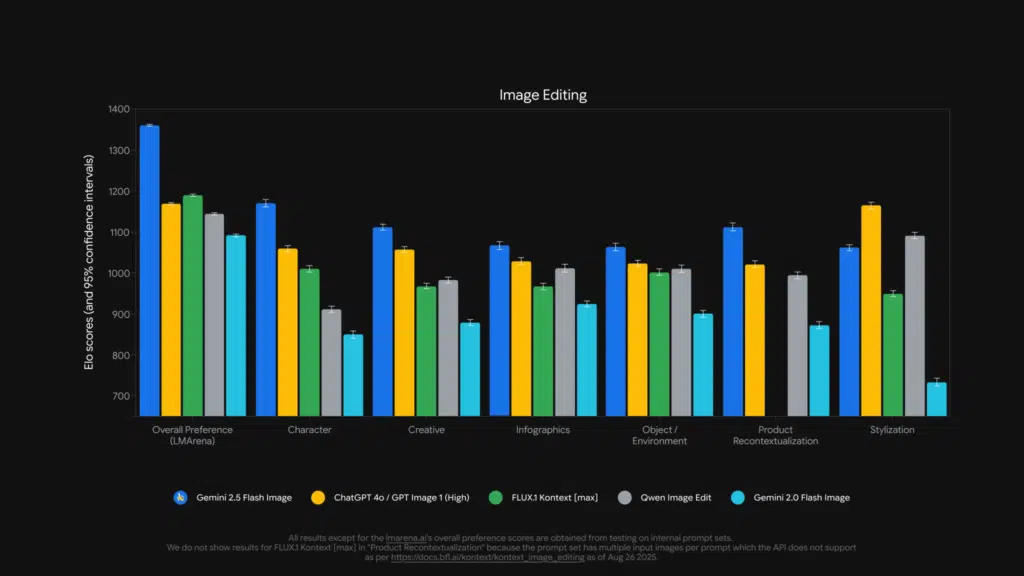

Em termos de precisão, o Google afirma que o novo modelo é “state of the art” no LMArena e em outros benchmarks de edição. Isso inclui tarefas como inpainting, alterações seletivas por máscara e composições multi-referência sem perder identidade visual — um calcanhar de Aquiles notório em geradores concorrentes.

- Pontos-chave: corrida por qualidade, controle e consistência.

- Meta licencia modelos; FLUX lidera em várias métricas.

- Google busca reduzir gap de usuários frente ao ChatGPT.

“Nano-banana” no LMArena: o mistério era o Gemini

Nas últimas semanas, um editor anônimo apelidado de “nano-banana” chamou atenção no LMArena por resultados surpreendentes. O Google confirmou que estava por trás do modelo — de fato, trata-se da capacidade nativa de imagem do Gemini 2.5 Flash. Pistas “bananescas” em redes sociais já insinuavam a autoria, inclusive em posts do CEO do Google DeepMind, Demis Hassabis.

Mais do que marketing, a identificação do “nano-banana” sinaliza a maturidade do editor nativo para casos reais, sem necessidade de contornos extensos ou edições manuais posteriores.

Segurança, limites e rotulagem de conteúdo

Após episódios de falhas em salvaguardas no passado, o Google afirma ter calibrado melhor os limites do gerador. A empresa proíbe, em seus termos, a criação de “imagens íntimas não consensuais” e aplica marcas d’água visuais e identificadores nos metadados para ajudar a rastrear conteúdo gerado por IA. Ainda assim, a empresa reconhece que, em redes sociais, usuários podem não verificar metadados, o que mantém o risco de desinformação. O debate ganha força especialmente após reclamações de que o Grok, da xAI, permitiu imagens explícitas que lembram celebridades.

Casos de uso: da sala de estar ao paisagismo

O 2.5 Flash Image foi pensado com foco no consumidor. Projetos domésticos de decoração e jardim, por exemplo, se beneficiam do entendimento de “mundo real” do modelo e da habilidade de combinar diversas referências em um único prompt. É possível mesclar a foto de um sofá com a imagem da sala e um conjunto de cores para visualizar rapidamente uma composição coerente, refinando a cada nova instrução.

Disponibilidade e como acessar

A atualização começa a ser liberada hoje no app do Gemini para usuários finais e para desenvolvedores via Gemini API, Google AI Studio e Vertex AI. Para quem já usa o ecossistema Google Cloud, a adoção tende a ser direta, especialmente em fluxos de edição dentro de apps, pipelines de ecommerce e catálogos visuais. Como sempre, a disponibilidade completa pode ocorrer de forma gradual por regiões e contas.

“Queremos dar controle criativo para que usuários obtenham do modelo o que desejam. Mas não vale tudo.”

Nicole Brichtova, Google DeepMind

Para desenvolvedores, um quick start envolve enviar uma imagem base, definir áreas-alvo por prompt ou máscara e iterar com instruções curtas. Na API, parâmetros como força de edição, preservação de rosto e nível de consistência podem equilibrar criatividade e fidelidade.

Transparência editorial: este artigo se baseia em informações divulgadas pelo Google e em entrevista concedida à imprensa internacional. Dados comparativos de uso foram citados em chamadas de resultados e reportagens recentes.

Perguntas frequentes sobre Google Gemini imagem

O que é o Gemini 2.5 Flash Image?

Resposta direta: É o novo modelo de imagem do Google Gemini com editor nativo preciso. Expansão: Ele executa edições finas por linguagem natural, preserva rostos/fundos e combina múltiplas referências em um único prompt. Validação: Google afirma liderança em benchmarks e liberou o recurso no app, API, AI Studio e Vertex AI.

Como usar o editor de imagem no Gemini?

Resposta direta: Abra o app, envie a imagem e descreva a edição desejada. Expansão: No fluxo multi-turn, refine com novos prompts (ex.: mudar cor, inserir objeto, ajustar luz). Em API/Vertex, configure parâmetros de consistência e força de edição. Validação: Recurso começa a ser liberado hoje e pode chegar gradualmente por região.

Quais são os limites e proteções de uso?

Resposta direta: Há bloqueios para imagens íntimas não consensuais e conteúdo sensível. Expansão: O Google aplica marcas d’água e metadados para identificação; ainda assim, quem rola o feed pode não notar os indicadores. Validação: Medidas seguem os termos de serviço e reações a falhas anteriores do gerador de imagens.

O que foi o ‘nano-banana’ do LMArena?

Resposta direta: Era o editor de imagem do Gemini testado de forma anônima. Expansão: O modelo chamou atenção por qualidade e consistência; pistas em redes sociais indicavam o Google, confirmado depois. Validação: O desempenho foi destacado em benchmarks públicos como o LMArena.

Como o Gemini se compara a ChatGPT e outros?

Resposta direta: O foco é precisão de edição e consistência de identidade. Expansão: ChatGPT se destaca em uso massivo; Meta licencia a Midjourney; FLUX lidera diversos testes. O Google mira fechar a lacuna com o 2.5 Flash Image. Validação: Indicadores recentes citam 700M semanais no ChatGPT e 450M mensais no Gemini.

Considerações finais

O upgrade “bananas” do Gemini 2.5 Flash Image ataca um ponto sensível da geração e edição por IA: preservar a identidade enquanto oferece liberdade criativa. Com promessas de edições mais limpas, refinamento por conversas e composições multi-referência, o Google posiciona seu modelo para uso real no dia a dia — de projetos de casa e jardim a catálogos de varejo e campanhas. O sucesso, porém, dependerá do equilíbrio entre qualidade, custo e guardrails efetivos num ecossistema em que fluidez e confiança são igualmente essenciais.